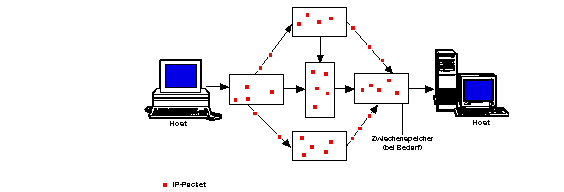

Das Internet entstand Anfang der 70er Jahre als Nachfolger des ARPA-Netzes. ARPA ist die Abkürzung für Advanced Research Projects Agency und ist der Vorläufer der heutigen DARPA, der Defense Advanced Research Projects Agency, ein militärischer Forschungsdienst der Vereinigten Staaten Amerikas. Somit war das ARPAnet zunächst nur ein Netz zu Forschungszwecken. Eines der damaligen Hauptziele aus militärischer Sicht war es, ein Netzwerk zu schaffen, welches weltweit verteilte Rechner miteinander verbindet und auch dann noch funktioniert, wenn Teile des Netzes ausgefallen sind - z.B. als Folge eines Bombardements durch den Feind. Nach dem ARPAnet Modell geschieht Kommunikation immer zwischen einem Quell- und einem Ziel-Computer. Es wird dem Modell nach ferner angenommen, daß das Netzwerk selbst unzuverlässig ist; jeder Teil des Netzes kann in jedem Moment ausfallen. Daher wurde das Design so ausgelegt, daß von den Computern nur die absolut notwendigste Information abgerufen werden muß. Um eine Nachricht über das Netz zu verschicken, muß der Computer die Daten lediglich in einen Umschlag" - einem sogenannten Internet Protocol (IP) Paket - stecken und an den richtigen Ziel-Computer adressieren".

Für den Kommunikationsaufbau und den -ablauf sind die miteinander kommunizierenden Computer und nicht das Netzwerk selbst verantwortlich. Dem Modell liegt die Philosophie zugrunde, daß jeder am Netz angeschlossene Rechner als Anlaufstelle mit jedem anderen Computer kommunizieren kann. 1 Die ersten Rechner wurden 1969 miteinander vernetzt. Acht Jahre später, 1977, waren im ARPAnet etwa 50 Sites 2 angeschlossen.

Obwohl seit Ende der 60er Jahre die Entwicklung von neuen Netzwerk-Architekturen und neuen Netzwerk-Standards erheblich fortgeschritten ist, ändert dies nichts an der Tatsache, daß die IP-Netzwerke gerade wegen der längeren Verfügbarkeit heute eine dominante Rolle am Markt spielen. IP-Software wurde schon bald - zumeist an Hochschulen - für jeden erdenklichen Computer-Typ entwickelt und war kostenlos nutzbar. Hierin besteht ein unübersehbarer Vorteil - können auf diese Art und Weise Computer unterschiedlichster Hersteller mit unterschiedlichen Betriebssystemen miteinander kommunizieren. US-Regierung und Universitäten - die anfänglichen Nutzer des IP-Netzes - begrüßten diese Herstel-lerunabhängigkeit und somit größere Flexibilität beim Hardware-Einkauf sehr.

Etwa eine Dekade später kündigte sich ein neuer Standard zur Vernetzung von Computern an - Ethernet. Er ist maßgeblich ein Ergebnis der Forschungs- und Entwicklungsaktivitäten am Xerox Palo Alto Research Center. Die Firmen DEC, Intel und Xerox legten daraufhin im Jahre 1980 als Ergebnis die Spezifikation dem Local Network Standards Committee des IEEE vor. Diese Spezifikation wurde als Committee 802" (IEEE 802) veröffentlicht und ist in sechs Unterkomitees organisiert. 3 Neben diesem neuen Standard, der sich zur Schaffung und Etablierung von LANs (Local Area Network) eignete, tauchte in der Computer-Szene plötzlich ein neuer Computer-Typ auf - sogenannte Workstations. Sie waren zumeist mit dem Berkeley UNIX-Betriebssystem ausgestattet, in welchem das IP-Netzwerkprotokoll enthalten war. Dies schuf ein neues Bedürfnis seitens der Anwender: Man wollte nicht mehr einzig und allein Großrechner à la PDP 11 4 als Sites einsetzen, sondern ganze lokale Netze sollten den Anschluß an das ARPAnet nach dem Willen der Anwender bekommen. Ein offenkundiger Vorteil - konnte doch so jeder am lokalen Netz angeschlossene Rechner in den Genuß des ARPAnets kommen. Anders ausgedrückt: Jeder könnte mit jedem kommunizieren. Es war daher nur ein logischer Schritt verschiedenster Organisationen, interne Netzwerke dem Kommunikations-Protokoll des ARPA-Netzes und seinen Ablegern anzupassen. 5

Zu einem dieser neueren verwandten Netzwerke gehört das NSFNET, welches von der National Science Foundation (NSF) - einer Behörde der US-Regierung - unterhalten wird. Als die NSF Mitte der 80er Jahre fünf Super-Computer-Centren errichtete, sollten diese miteinander vernetzt werden, um eine möglichst gute Ausnutzung der Ressourcen dieser Centren zu ermöglichen. Hierbei muß man beachten, daß diese Centren zum damaligen Zeitpunkt an die technischen Grenzen im Bereich des Computing heranreichten und daher enorm kostenintensiv waren. Undenkbar, daß einzelne Unternehmen sich eine derartig leistungsfähige und kostenintensive Infrastruktur hätten einrichten können - von Privatpersonen oder Hochschulen ganz zu schweigen. 6 Neben Kostengründen war es auch aus wissenschaftlichen Gründen wünschenswert, Clients den Zugriff auf diese Super-Computer-Centren zu ermöglichen. Was also hätte näher gelegen, als diesem Kommunikationsproblem durch die Benutzung des ARPA-Netzes beizukommen?

Da scheinbar bürokratische Gründe gegen eine Anbindung an letzteres sprachen, entschloß sich die NSF, ein eigenes Netzwerk ins Leben zu rufen, welches auf der vom ARPA-Netz schon bekannten IP-Technologie aufbaute. Mithin wurden die Centren der NSF via Telefonleitung bei einer Transfer-Rate von 56 Kbps miteinander vernetzt. Aus heutiger Sicht ist dies eine eher zu belächelnde Rate - entsprach Mitte der 80er Jahre aber dem State-of-the-Art in Sachen Geschwindigkeit. Alles wäre so schön gewesen, hätten sich die zahlreichen amerikanischen Universitäten ebenfalls direkt via Telefonleitung an das NSF-Netz anklinken können. Die Gebührenordnungen der privaten amerikanischen Telefon-Gesellschaften, die sich an der Länge der Leitung orientieren, machten dieser Idee jedoch einen Strich durch die Rechnung. Um diesem Dilemma zu entkommen, begann man mit der Schaffung von regionalen Netzwerken. Regional heißt, jede Hochschule wurde mit den ihr benachbarten Hochschulen vernetzt. Einige dieser Hochschulen würden schließlich sicherlich in der Nähe von einem der fünf Centren sein, so daß weiter entfernte Hochschulen über mehrere Nachbarn hinweg mit dem am nächsten gelegenen Super-Computing-Center verbunden waren. Da die Centren selbst auch vernetzt waren, reichte schließlich die Verbindung an nur eines der Centren, um letztlich mit allen verbunden zu sein.

Nun zeigte sich sehr bald, daß die Hochschulen nicht ausschließlich vom Zugriff auf die Centren Gebrauch machten - auch der Kommunikationsbedarf der einzelnen Hochschulen untereinander wuchs stetig an. In der Folge stieg das Datenaufkommen im NSF-Netz stark an und die Leistungsgrenzen des Netzes wurden sehr schnell erreicht.

Gemäß dem Motto Nichts geht mehr!" fing man 1987 mit Modernisierungsmaßnahmen an. Schnellere Telefonleitungen und schnellere Computer, die an diese angeschlossen waren, mußten (und müssen bis heute) her. Die Probleme sind im Grunde sehr analog zu denen unserer Straßenverkehrsnetze. Allerdings bemerken wir die Baustellen" in unseren Datennetzen nicht so sehr, wie es bei den Baustellen der Straßennetze der Fall ist. Die Wahrscheinlichkeit einer Sperrung eines bestimmten Autobahnabschnitts oder einer Ausfahrt für längere Zeit ist jedenfalls um einiges größer, als die längere Unerreichbarkeit eines Sites.

Der wohl wichtigste Aspekt des NSF-Netzes ist das Aufbrechen der Benutzer-Strukturen. War das ARPAnet einer Oligarchie bestehend aus Regierungsbeamten, Militär und einigen Wissenschaftlern vorbehalten, so hat durch das NSF-Netz ein regelrechter Demokratisierungsprozeß begonnen.

Im vorherigen Abschnitt wurde mittels der Entstehungsgeschichte ein Bild davon vermittelt, was sich hinter dem Begriff Internet" verbirgt. Eine klare Definition wurde dort nicht vorgenommen. Der Grund ist recht einfach: Es gibt keine eindeutige Definition. Ein Blick in den als Nachschlagewerk so renommierten Duden der Informatik 7 hilft hier auch nicht weiter. Der Begriff wird dort nicht explizit aufgeführt.

Ein Stück weiter kommt man mit dem Verein zur Förderung eines Deutschen Forschungsnetzes e.V. (DFN): Der Terminus `Das Internet' steht i. A. für die Menge der nach einheitlicher Architektur und Protokollwelt aufgebauten, weltweit verteilten und zentral administrierten Netze (im engl. als `internets' bezeichnet, zur Unterscheidung von dem `Internet' in Kleinschreibung)." 8

Daß man heute mit dieser recht präzisen bzw. engen Interpretation des Begriffs Internet nicht unbedingt konform gehen muß, zeigt Ed Krol, indem er sagt: What compromises the Internet is a difficult question; the answer changes over time. Five years ago the answer would have been easy: `All the networks, using the IP protocol, that cooperate to form a seamless network for their collective users.' This would include various federal networks, a set of regional networks, campus networks, and some foreign networks." 9

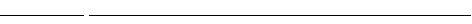

Wegen der vielen Vorteile des Internet - wie z.B. seine globale Erstrekkung - macht sich in den letzten Jahren ein scheinbar immer stärker werdender Trend bemerkbar: Eine Reihe artfremder" Netze (z. B. das DECnet, das Bitnet, Fidonet u.v.m.) fanden die Anbindung an das Internet. Diese technische Brücke" der auf unterschiedlichen Protokollen aufbauenden artfremden Netze wird als Gateway bezeichnet. Anfänglich dienten diese Gateways lediglich dem Austauch von Electronic-Mail zwischen unterschiedlichen Netzen - die Gateways wurden also nur für relativ geringe Informationsmengen verwendet, um den Benutzern der Fremdnetze die Anbindung an das schicke" Internet zu ermöglichen. Inzwischen kann man selbst kommerzielle Netzbetreiber wie CompuServe über das Internet erreichen. Hierzu kommen sogenannte Full Service Translators" zum Einsatz - eine Art sehr leistungsfähiger Gateways. Wie am Beispiel von CompuServe recht gut ersichtlich wird, ist die Beantwortung der Frage, ob CompuServe nun ein Teil des Internet oder eben nur" das kommerzielle CompuServe-Netz ist, eine, bei der Emotionen wohl auch eine Rolle spielen; in einem technischen Zusammenhang zwar sehr holprig - es ist aber gar nicht so verkehrt. Ed Krol weist darauf hin, indem er sagt: In many ways the Internet is like a church: it has its council of elders, every member has an opinion about how things should work, and you can either take part or not. It`s your choice." 10

Im Verlauf der letzten Jahre wurde das Internet zunehmend auch auf kommerzieller Basis genutzt. Die sogenannte Acceptable Use Policy" der NSF schloß jedoch die Übertragung von kommerziellen Daten über das NSFNET (NSF-Backbone) noch bis Mitte der 90er Jahre aus. Allerdings ist das NSF-Backbone auch nicht mehr identisch mit dem Internet-Backbone. Außer dem NSF-Backbone gibt es z.B. in Nordamerika noch zwei große, kommerzielle Internet-Netzwerke: das von Advance Network Services (ANS, Elmsford, N.Y., USA) betriebene ANS-Netzwerk sowie CIX (Commercial Internet Exchange), ein nationaler Zusammenschluß der Netzwerke der größten nordamerikanischen Internet-Betreiber Performance Systems International (PSI), Uunet Technologies und General Atomics. Seit 1995 befinden sich etwa 50% aller Internet-Anschlüsse in der Hand privater Unternehmer.

Die Beschränkung im NSFNET auf die Übertragung von Daten aus dem Forschungs- und Bildungswesen ist seit 1995 ausgelaufen. Dies geht einher mit einer Zahlungseinstellung von öffentlichen Geldern zum Betrieb des NSF-Backbone und macht Kooperationen der National Science Foundation mit privaten Investoren zwingend notwendig. Wie sich das auf das Internet als Forschungs- und Wissenschaftsnetz auswirken wird, ist noch völlig unklar und Gegenstand sehr kontroverser Diskussionen.

In einem Fernsehinterview im Zusammenhang mit dem Internet-Boom als Massenmedium danach befragt, ob das Internet eine Quasselbude oder großartige technologische Revolution" 11 sei, antwortete der renommierte MIT Professor und Computer-Pionier und -Kritiker Joseph Weizenbaum: Also, beides würde ich sagen. Erstens, [...] von einem naturwissenschaftlichen und technologischen Standpunkt aus betrachtet, muß man wirklich stolz sein, daß die Menschheit das geschafft hat. So, als ein technisches Mittel ist es einfach herrlich. Aber man muß das unterscheiden wie mit so vielem in unserer Welt, z.B. Fernsehen - auch ein technisches Wunder; zwischen der Technologie und dem, was da drin ist - also der Inhalt. Fernsehen würde ich sagen ... es ist mir ganz klar, daß das Fernsehen eine Katastrophe ist. Und ich glaube das Internet ist nicht viel anders, d.h. ein großer Teil davon - ich meine jetzt den Inhalt und auch die Nutzung - ist einfach Quatsch. Oder unsinnig oder sogar wahnsinnig, z.B. wie die Leute miteinander in Anführungsstrichen sprechen. Das Wort `chat' wird benutzt. Wenn man manche dieser Gespräche verfolgt, dann sieht man, wie ungeheuer oberflächlich und trivial alles ist - das ist eine Sache. Aber man muß auch sagen - und das gilt so auch für andere Massenmedien wieder mal Fernsehen [!] - es gibt Perlen. Es gibt wirkliche Perlen! Und die Leute, die das Internet benutzen - beruflich, für Forschung z.B in einer bestimmten Domäne, in der sie selbst Experte sind, sagen wir Biologen, Ärzte oder wer auch immer. Die können das Internet sehr wohl benutzen!" 12

Folgt man den Gedanken von Weizenbaum, so stellt sich nicht mehr die Frage, ob eine Kommerzialisierung des einstigen Forschungsnetzes Internet aufzuhalten sei, da sie inzwischen durch den großen Internet-Boom zwischen 1995 bis 1997 beantwortet worden ist. Die Benutzerstrukturen und auch die Inhalte außerhalb des Forschungs- und Ausbildungsbereichs sind inzwischen im Internet dominant. Der Anteil der Studenten im Internet betrug Ende 1995 ca. 48% und sank bis Ende 1996 auf ca. 30%. 13 Dies bedeutet jedoch nicht unbedingt eine Vermarktung von Forschung und Wissenschaft - jedenfalls solange man die Perlen", die Weizenbaum ansprach, noch finden kann.

In diesem Zusammenhang sollte man zweierlei beachten: Zu dem Zeitpunkt, als das Internet noch gleichbedeutend mit einem Forschungsnetz gesehen wurde, mangelte es an einer einheitlichen Benutzeroberfläche, die schließlich durch ein Programm im Zuge der Erfindung vom World Wide Web 1993 als Leistung der Wissenschaft für die Wissenschaft erbracht wurde. Erst eine mit Mausklick-Interaktion und grafischer Benutzeroberfläche ausgestattete Software, die auf dem Hypertext- bzw. Hypermedia-Prinzip basiert und auf allen unterschiedlichen Computer-Plattformen gleich (einfach) zu bedienen ist, hat das Internet als Massenmedium - über den Bereich der Forschung hinaus - populär gemacht. Die Forschung hat in der Entwicklung des WWW die Kommerzialisierung des Internet erst ermöglicht.

Im Jahr 1991 beschloß der amerikanische Kongreß im Rahmen des High Performance Computing Act (HPCA) die Einrichtung eines neuen Backbone-Netzes für Wissenschaft und Forschung - das NREN (National Research and Education Network). The NREN component will establish a gigabit communications infrastructure to enhance the ability of U.S. researchers and educators to perform collaborative research and education activities, regardless of their physical location or local computational and information resources. This infrastructure will be an extension of the Internet, and will serve as a catalyst for the development of the high speed communications and information systems needed for the National Information Infrastructure (NII)." 14

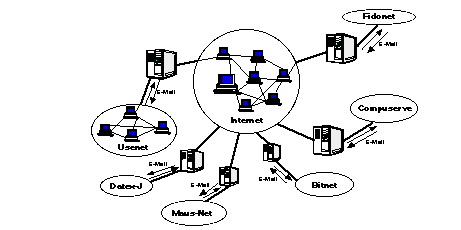

NREN ist eine Komponente im High Performance Computing and Communications Program (HPCC), dessen Einrichtung im High Performance Computing Act von 1991 beschlossen wurde. Das HPCC wurde in fünf Komponenten organisiert, deren Aufgaben im High Performance Computing & Communications Blue Book FY 1996 wie folgt beschrieben werden:

Ingesamt sind am HPCC Programm seit 1996 zwölf verschiedene Bundesbehörden bzw. Institutionen (Federal Departments) beteiligt:

Das Ziel des Federal High Performance Computing and Communications (HPCC) Program ist die Beschleunigung bei der Entwicklung zukünftiger Generationen von Hochleistungs-Computern und -Netzwerken und deren Einsatz in der Regierung und der gesamten amerikanischen Wirtschaft. Skalierbare Hochleistungs-Rechner, fortschrittliche Hochgeschwindigkeits-Computer-Kommunikations-Netzwerke und fortschrittliche Software sind kritische Komponenten einer neuen National Information Infrastructure (NII)". 16 Im Jahr 1994 wurden dafür in den USA mehr als eine Milliarde US-$ ausgegeben. Die Ergebnisse der HPCA-Projekte sollen die Grundlage für die Realisierung einer neuen, nationalen Informationsinfrastruktur bilden.

Die im September 1993 von US-Vizepräsident Al Gore zur Chefsache erklärte NII-Initiative soll innerhalb von 15 Jahren Kommunikationsstrukturen schaffen, die jedermann den Zugang zu multimedialer Datenkommunikation eröffnen sollen. Dafür werden bis zum Jahr 2007 mehr als 500 Milliarden US-$ zur Verfügung gestellt. Dem Internet wird im Rahmen der NII-Initiative eine zentrale Rolle zufallen. Innerhalb der bestehenden Internet-Strukturen ist geplant, die neuen HPCA-Technologien zunächst in Großversuchen zu testen. Darauf aufbauend soll dann in weiteren Schritten die Infrastruktur für einen national verfügbaren multimedialen Informationsdienst ausgebaut werden.

Die Koordination des High Performance Computing and Communications Program (HPCC) und anderer Projekte erfolgt durch das National Coordination Office (NCO) for Computing, Information, and Communications (CIC). Das NCO ist für Planung und Budget des HPCC-Programms zuständig. Außerdem leistet es technische und administrative Unterstützung für das Committee on Computing, Information, and Communications (CCIC): The NCO provides a central point of CCIC contact to the U.S. Congress, federal agencies, state and local organizations, foreign organizations, academia, industry, and the public." 17 . Das CCIC ist eines von neun Komitees, das an das National Science and Technology Council (NSTC) berichtet. Letzteres bildet, wie in der Abbildung 3 auf Seite 21 ersichtlich wird, die Schnittstelle zum Präsidenten und zur Regierung der Vereinigten Staaten von Amerika.

Anfang 1997 hat das CCIC seine gemeinschaftlichen Forschungsprogramme - mithin auch das HPCC - im neugebildeten Computing, Information, and Communications R&D (CIC) Subcommittee of the CCIC reorganisiert. 18 Dieses Unterkomitee besteht aus fünf Program Component Areas (PCAs), deren Struktur sich aus den ursprünglichen fünf Komponenten des HPCC Programms (HPCS, NREN, ASTA, IITA und BRHR) entwickelt hat. Mit den PCAs sollen die Bereiche abgedeckt werden, in denen die Federal Agencies (Bundesbehörden) hohe Priorität für Investitionen sehen. Die fünf Program Component Areas und ihre Ziele sind im einzelnen dem HPCC FY 1997 Implementation Plan zu entnehmen:

The goal of HECC R&D is to provide the foundation for U.S. leadership in computing through investments in leading-edge hardware and software innovations, and in algorithms and software for modeling [!] and simulation needed to address Grand Challenge-class applications.

The goal of LSN R&D is to assure U.S. leadership in communications in high performance network components; technologies that enable wireless, optical, mobile, and wireline communications; large-scale network engineering, management, and services; and systems software and program development environments for network-centric computing.

The goal of HCS R&D is to develop technologies that provide users with high levels of security, protection of privacy and data, reliability, and restorability of information services.

The goal of HuCS R&D is to make computing and networking more useful through collaboratories, technologies that provide knowledge from distributed repositories, multi-modal interactive systems, and virtual reality environments.

The goal of ETHR R&D is to support research that enables modern education and training technologies, including technologies that support lifelong and distance learning, and curriculum development." 19

Mithin stellt der Information Superhighway in den USA ein nationales Anliegen dar, welches als größtes Investitionsprojekt der 90er Jahre dem Land zum Sprung aus dem industriellen Zeitalter ins Informationszeitalter des 21. Jahrhunderts verhelfen soll. Der Staat soll die politischen Rahmenbedingungen festlegen, während die Gelder zum größten Teil aus der privaten Wirtschaft kommen sollen. Die Realisierung des Information Superhighway umfaßt sehr ergeizige Zielsetzungen, die nur durch ein Zusammenwirken von Wissenschaft, Forschung, Militär, Politik und Privatwirtschaft erreicht werden können.

Der High Performance Computing Act von 1991 gab den Anstoß zu einer Vielzahl öffentlicher und privater Projekte innerhalb wie außerhalb der Vereinigten Staaten von Amerika. Einige Beispiele sollen zeigen, inwiefern staatliche und private Träger an der NII-Initiative beteiligt sind und die Auswirkungen über die USA hinaus als eine neue Global Information Infrastructure (GII) zu verstehen sind.

Als eine der fünf Program Component Areas der CIC, hat die Large Scale Networking Working Group (LSN) ihre Ziele in einem Briefing vom 27. Februar 1997 an das Presidential Advisory Committee formuliert. 20 Demnach umfassen die Ziele dieser Arbeitsgruppe unter anderem:

Die als Next Generation Internet Initiative formulierten Ziele der LSN sind in der Tabelle 1 wiedergegeben. Für die in der linken Spalte genannten Ziele 1.-3. veranschlagt die LSN zwischen 1998 bis 2002 ein Budget von 500 Millionen US-$. Eine detaillierte Aufschlüsselung dieser Zahl ist der Tabelle 2 zu entnehmen.

Unter Verwendung dieses Budgets will die LSN zwischen 1999 und 2002 eine Reihe von Leistungen erbringen, die in Tabelle 3 aufgeführt werden. Diese Vorgaben sind sehr beeindruckend und der straffe Zeitplan, auf den sie festgelegt sind, zeigt sehr deutlich, daß der staatliche zusammen mit dem akademischen Sektor die Grundlagen für die Entwicklung und Erprobung von Hochgeschwindigkeit-Netzwerken erbringen soll.

|

1998 |

|||||

|---|---|---|---|---|---|

|

Goal 1.1 21 |

|||||

Die technologischen Lösungen, die aus dem Forschungsbereich hervorgehen, sollen dann privates Investitionskapital binden, mit dessen Hilfe Hochgeschwindigkeits-Netzwerke nicht nur als testbed, sondern auch national (NII = National Information Infrastructure) und global (GII = Global Information Infrastructure) realisierbar werden.

Man kann an dieser Stelle zwei Fragen stellen: 1. Welche Bereiche des Privatsektors wären am ehesten bereit, in Hochgeschwindigkeits-Netzwerke zu investieren? 2. Über welche Anwendungen/Nutzungen sollen diese Ausgaben wieder amortisiert werden? Investitionen können praktisch für alle Netzbetreiber-Gesellschaften interessant sein - hierzu zählen die verschiedenen Telefon- und Kabel-Netzbetreiber. Sie könnten durch die enorme Bandbreite ganz neue Dienstleistungen auf globaler Ebene anbieten, die sehr wahrscheinlich in multimedialen Kommunikationsabläufen eine gemeinsame Eigenschaft teilen werden.

Zu den vielgenannten Netzwerk-Anwendungen des 21. Jahrhunderts gehören sicherlich Audio-/Video-on-demand, Konferenz- und 3D-/VR-Anwendungen. Auch durch das Bereitstellen von Leitungs- und Server-Kapazitäten lassen sich weitere Einnahmen erzielen. Im Internet hat diese als Provider-Business bezeichnete Dienstleistung in den letzten Jahren einen starken Boom erlebt. Ähnliches könnte sich auf dem zukünftigen Information Superhighway abspielen. Im Zuge der digital convergence werden natürlich nicht nur Telefon-Gesellschaften Interesse an diesen Netzen haben. Hollywood könnte uns - natürlich gegen Bezahlung - grenzenlosen Spaß in jeden Winkel und jedes Wohnzimmer dieser Erde bringen. Es gibt sicherlich noch viele andere Branchen, die in den Information Highway investieren werden, und man sollte auch daran denken, daß sich die Branchen derzeit selbst gerade wegen der digital convergence in einem Wandel befinden. An den Investitionen vom Software-Giganten Microsoft in den Mediensektor läßt sich dies gut nachvollziehen.

Für die Telefon-Gesellschaften lohnt sich die Investition in den Information Superhighway - mithin Hochgeschwindigkeits-Netze - in mehrfacher Hinsicht. Durch die im Punkt AV-Programme im Internet von heute" beschriebenen Anwendungen sind die Finanzierungspläne aus dem Telefongeschäft mittelfristig hinfällig, nämlich dann, wenn erst einmal die long-distance Internet-Telefonie zum Ortstarif gang und gäbe wird. In diesem Fall sind die Telefon-Gesellschaften geradezu gezwungen in andere Telekommunikations-Dienstleistungen hinein zu diversifizieren. Dafür werden Hochgeschwindigkeits-Netze als Infrastruktur benötigt.

Die Modernisierung der Netz-Infrastruktur durch den Ausbau von Hochgeschwindigkeits-Netzwerken bringt für die Telefon-Gesellschaften eine willkommene Umstellung von Kupfer auf Glasfaser mit sich. Today, fiber is cheaper than copper, including the cost of the electronics at each end. If you come across a condition where this is not true, wait a few months, as the prices of fiber connectors, switches, and transducers are plummenting." 22 Neben dem Preisvorteil, den Glasfaser gegenüber Kupfer bietet, ist es auch noch wartungsfreundlicher. Zur Zeit ersetzen die amerikanischen Telcos (Telco = Telephone Company) jährlich 5% ihrer (Kupfer-) Netze durch Glasfaser. 23 Legt man diese Zahl einmal zugrunde und geht davon aus, sie bliebe in den nächsten Jahren konstant, so wären die USA innerhalb von 20 Jahren durchgängig mit Glasfaser vernetzt. Die enormen Bandbreiten - sie werden also so oder so zur Verfügung stehen.

Ein Ableger der Mutter aller amerikanischen Telcos", die AT&T Submarine Systems Inc. (Morristown/New Jersey) wird bis Ende 1998 das leistungsstärkste Unterwasser-Telekommunikationsnetz der Welt einrichten." 24 Bei diesem Netz handelt es sich um ein auf dem Atlantikboden verlegtes Glasfasernetz mit dem Namen Atlantic Crossing 1, welches eine Länge von über 14.000 Kilometern besitzen wird. Es verbindet die USA, Deutschland und Großbritannien direkt miteinander und soll die für Internet- und Multimedia-Anwendungen benötigten Übertragungsleistungen bereitstellen.

Einen weiteren Vorstoß zur Verwirklichung des Information Superhighway ist das gigantische Projekt Oxygen der amerikanischen Firma CTR: Geplant ist ein Untersee- und Überland-Glasfasernetz von 275.000 km Länge mit 262 Einwahlknoten in 175 Ländern. Die Übertragungsrate soll zunächst mindestens 100 Gigabit pro Sekunde betragen und später stellenweise auf mehr als 1 Terabit pro Sekunde (1 Trillion Bits) erweitert werden. Als zeitliche Vorgabe für die Inbetriebnahme dieses Mammut-Projekts wird das Jahr 2000 und für die Beendigung der Verlegung zu allen Kontinenten (außer der Antarktis) das Jahr 2003 gegeben. 25

Warum die Beantwortung der Frage, was das Internet ausmacht, nicht eindeutig ist und sich die Antwort im Verlauf der Zeit ändern kann, wurde schon im Punkt Definition Internet" auf Seite 11 erörtert. Der Bedeutungswandel, der vom Begriff Internet ausgeht, verhindert allerdings nicht, daß das Internet in der Literatur in seiner gegenwärtigen Form häufig als Vorläufer des Information Superhighway beschrieben wird. Folgt man diesem Ansatz, so müssen das Internet und der zukünftige Information Superhighway über gemeinsame Eigenschaften verfügen, da das Internet als Grundlage für den anvisierten Information Superhighway angesehen wird. Andererseits werden die beiden Begriffe durch diese Aussage auch voneinander abgegrenzt. Daraus läßt sich folgern, daß der Information Superhighway zusätzliche Eigenschaften besitzen wird, die ihn vom Internet unterscheiden.

Als ein Verbund zahlreicher Teilnetze (internets) bildet das Internet eine globale Infrastruktur zur Übertragung digitaler Daten. Auch der Information Superhighway wird als weltumspannendes Netzwerk für digitale Daten gesehen. Folgt man dem fundamentalen Kommunikationsmodell, wie es durch die Informationstheoretiker Shannon und Weaver beschrieben wurde, so teilen Internet und Information Superhighway die Eigenschaft, aus physikalischer Sicht ein Informationsübertragungssystem zu sein. 26 Shannon soll mit dem Wort Information nicht sehr glücklich gewesen sein und hat es in seiner Theorie als einen rein quantitativen Maßstab zur Messung des kommunikativen Austauschs definiert. 27 Über Art und Struktur der Information sagt diese Definition nichts aus. Der Satz: Ich reise gern." besitzt die gleiche Menge an Information wie gerInch .serei". In späteren wissenschaftlichen Ansätzen auf der Grundlage von Shannon's Informationstheorie wurde der Begriff Signalübertragungstheorie geprägt. 28 Anstelle der Bezeichnung Informationsübertragungssystem" wird i.d.S. auch der Begriff Signalübertragungssystem" verwendet.

Wenn das Internet und der Information Superhighway die Eigenschaft teilen, physikalisch ein Signalübertragungssystem zu sein, müssen sie sich in anderen Eigenschaften unterscheiden, die eine Abgrenzung der Begriffe kennzeichnen. Die Abgrenzung der Begriffe kann erfolgen, wenn man die physikalischen Eigenschaften eines Signalübertragungssystems in eine Betrachtung miteinschließt. Unterschiede bei den physikalischen Eigenschaften wirken sich auf die Leistungsfähigkeit des Signalübertragungssystems aus.

Setzt man die quantitative Leistungsfähigkeit eines Signalübertragungssystems - über den Ansatz von Shannon hinaus - in Beziehung zu Art und Struktur der Information und den damit möglichen Gebrauchsformen, werden die Eigenschaften deutlich, die das Internet vom Information Superhighway unterscheiden sollen.

Als globale Infrastruktur für digitale Daten dient das Internet als Übertragungssystem für Dateien und Programme, Informations- und Kommunikationssystem und dem Fern-Zugriff auf Computer-Systeme. Für diese Gebrauchsformen entstanden eine Reihe verschiedener Dienste zur Informationsübertragung im Internet:

Diese klassischen" Dienste des Internet sind nicht multimedial sondern textbasierte Systeme. 29 Sie sind daher für eine geringe Netz-Bandbreite gut geeignet. Allerdings ist die Nutzung dieser Dienste unter einem Betriebssystem (und schon gar nicht über verschiedene Betriebssysteme hinweg) nicht durch ein bestimmtes Anwendungsprogramm und eine einheitliche Benutzeroberfläche standardisiert. Das Ergebnis sind etliche verschiedene Programme, um z.B. Dateien zu transferieren, news zu lesen oder e-mail zu verschicken. Der Nachteil für den Benutzer ist eine fehlende, standardisierte Benutzerführung.

Erst mit dem World Wide Web (WWW) wurde 1993 der Grundstein für einen moderneren Online-Dienst gelegt, dessen herausragendste Eigenschaften eine - über verschiedene Betriebssysteme hinweg - einfache Bedienung und eine neue Form der Vermittlung und Übertragung von Information sind. Durch den Ausbau bzw. die Modernisierung der Netzwerk-Infrastruktur werden höhere Datenübertragungsraten erzielt, die Multimedia-Anwendungen im Internet ermöglichen. Die Möglichkeiten, über das Internet zu telefonieren, zu videokonferieren oder Video-on-demand zu betrachten bzw. Audio-on-demand zu hören, bestehen erst seit Mitte der 90er Jahre - mithin noch nicht so lange.

Für das 21. Jahrhundert werden Bandbreiten zur Verfügung stehen, die bis dahin undenkbare Anwendungen und Programme herbeiführen werden, die man als Anwendungen des Information Superhighway betrachten kann. Einige Anwendungen des staatlichen und akademischen Sektors benennt die Large Scale Networking Working Group (LSN) in ihrem Briefing. Sie sind in Tabelle 4 auf Seite 29 zusammen mit den benötigten Bandbreiten aufgeführt.

|

Battlefield awareness, Virtual Aerospace enviroment, Engineering |

||

|

Aerodynamics, astrophysics, Global Change, Stockpile Stewardship |

|

|

|---|

Weitere Anwendungen ergeben sich für die Bereiche, die sich hinter den Begriffen Tele- und Virtual-Shopping sowie Electronic Commerce verbergen. Wie realitätsnah und intensiv der Gedanke vom digitalisierten und globalen Markt ist, gibt die Absichtserklärung von US-Präsident Bill Clinton wieder, das Internet durch ein internationales Abkommen als eine weltweite Freihandelszone nutzen zu wollen. 30 Unter Wegfall zusätzlicher Steuern auf im Netz getätigte Geschäfte, erhofft sich die amerikanische Wirtschaft bis zur Jahrtausendwende Umsätze von 200 Milliarden US-$. 31

2. Ein Site ist ein am Netzwerk angeschlossener Rechner. Der Begriff stammt zwar aus dem Amerikanischen, wird von Netzwerk-Administratoren hierzulande - wie auch viele andere Termini - unübersetzt übernommen.

3. KARLSTETTER, Albert; Peter MAYR; Sonja WUNSCH (Hrsg.): Apple Handbuch Datenkommunikation und Netzwerke. Bonn, Paris, Reading, Mass. [u.a.] 1993, S. 47

6. Man bedenke auch, daß selbst der Personal-Computer gerade einmal eine Erfindung war, die Anfang der 80er Jahre von sich reden machte und noch sehr teuer war.

7. Vgl. DUDEN »Informatik«: Ein Sachlexikon für Studium und Praxis. 2., vollst. überarb. und erw. Aufl. . Mannheim etc., 1993.

8. DEUTSCHES FORSCHUNGSNETZ - DFN -: Handbuch zur Installation einer IP-Infrastruktur. Hrsg.: Verein zur Föderung eines Deutschen Forschungsnetzes e.V. - DFN-Verein -. 3. Auflage. DFN-Bericht Nr. 70. Berlin 1994, S. 3

11. BROCK, Markus: Allein unter Computern? Leben im Netz. - Gespräch mit Joseph WEIZENBAUM. In: TV-Sendung auf 3SAT am 28.03.1997. Südwestfunk: Baden- Baden 1996.

12. BROCK, Markus: Allein unter Computern? Leben im Netz. - Gespräch mit Joseph WEIZENBAUM. In: TV-Sendung auf 3SAT am 28.03.1997. Südwestfunk: Baden- Baden 1996.

13. HÜSKES, Ralf; Dusan ZIVADINOVIC; Axel KOSSEL: König Kommerz. Die Perspektiven des Internet. In: c't magazin für computer technik. April 1997, S. 226-230

14. HIGH PERFORMANCE COMPUTING & COMMUNICATIONS: Toward a National Information Infrastructure, FY 1994 Blue Book. Section III.2. National Research and Education Network Program (NREN). Online in Internet: URL: http://www.hpcc.gov/blue94/section.3.2.html, [Stand: 31.03.1997].

15. HIGH PERFORMANCE COMPUTING & COMMUNICATIONS: Toward a National Information Infrastructure, FY 1996 Blue Book. Section III. HPCC Program Organization. Online in Internet: URL: http://www.hpcc.gov/blue96/program.org.html, [Stand: 31.03.1997].

16. HIGH PERFORMANCE COMPUTING & COMMUNICATIONS: Toward a National Information Infrastructure, FY 1994 Blue Book. Section I.1. Executive Summary. Online in Internet: URL:http://www.hpcc.gov/blue94/section.1.html, [Stand: 31.03.1997].

17. NATIONAL COORDINATION OFFICE (NCO) FOR COMPUTING, INFORMATION, AND COMMUNICATIONS: NCO Mission. Online in Internet: URL: http://www.hpcc.gov/nco-facts/index.html, [Stand: 31.03.197].

18. Vgl. NATIONAL COORDINATION OFFICE: HPCC FY 1997 Implementation Plan. Online in Internet: URL: http://www.hpcc.gov/imp97/execsummary.html, [Stand: 31.03.1997].

19. NATIONAL COORDINATION OFFICE: HPCC FY 1997 Implementation Plan. 1. Executive Summary. Online in Internet: URL: http://www.hpcc.gov/imp97/execsummary.html, [Stand: 31.03.1997].

20. LARGE SCALE NETWORKING WORKING GROUP AND NEXT GENERATION INTERNET INITIATIVE: Briefing to the Presidential Advisory Committee. Online in Internet: URL: http://www.hpcc.gov/advisory-committee/lsn-27Feb97/, [Stand: 31.03.1997].

21. Note: Cost sharing may reduce cost of Goal 1.1 by $$M per year. Savings would be applied to increase Goal 3 budget.

25. HEISE NEWS-TICKER: Super-Internet ab 2000 in Aussicht. Online in Internet: URL: http://www01.ix.de/newsticker/data/dz-03.07.97-000/, [Stand 05.07.1997].

26. Vgl. SHANNON, Claude E.; Warren WEAVER: Mathematische Grundlagen der Informationstheorie. 1. Auflage. München 1976.

27. Vgl. SVEIBY, Karl Erik: What is Information?. Online in Internet: URL: http://www2.eis.net.au/~karlerik/Information.html, [Stand: 30.03.1997].

28. Vgl. SVEIBY, Karl Erik: What is Information?. Online in Internet: URL: http://www2.eis.net.au/~karlerik/Information.html, [Stand: 30.03.1997].

29. Sie erfüllen in dieser Hinsicht nicht alle der am Anfang aufgestellten Kriterien und werden deshalb hier nicht weiter erläutert.