Oft ist der Zusammenhang nicht sofort eindeutig, wer denkt schon bei einem Telefonat oder

beim Fernsehen an den militärischen Ursprung der Raketentechnik im Zweiten Weltkrieg,

ohne den es womöglich keine Fernmeldesatelliten gäbe, oder bei der Benutzung seiner

Textverarbeitungssoftware an den Ursprung des Computers.

Die Vorläufer des Computers, eine Art Zählmaschinen, wurden schon Anfang des 20. Jahrhunderts in den USA für zivile Zwecke eingesetzt.

Die ersten eigentlichen Computer wurden erst ein Jahrhundert später, ab den 30er/40er Jahren, in Deutschland, Großbritannien und den USA entwickelt und gebaut.

Erstaunlich ist, daß die Entwicklungen unabhängig und zur selben Zeit stattfanden, ohne die Kenntnis von Babbages Konzepten, was darauf hindeutet, daß aufgrund der gesellschaftlichen Verhältnisse, der geistigen Konzepte und der technologischen Gegebenheiten der Bau von Rechnern als zwangsläufiger Entwicklungsschritt interpretiert werden kann.

(Keil-Slawik 1985: S. 11)

Zwar waren die ersten Rechner auf mechanischer Basis konzipiert, jedoch war erst nach Erfindung elektromechanischer und elektronischer Bauteile wie Relais und Röhren an eine ernsthafte Entwicklung zu denken.

Der erste eigentliche Computer wurde am Anfang des Zweiten Weltkrieges in Deutschland von Konrad Zuse auf elektromechanischer Basis (Relais) und dann mit Röhrentechnik gebaut. Er war zwar nicht militärisch motiviert, wurde aber auch für militärische Zwecke genutzt. Offenbar wurden die Möglichkeiten der Rechenmaschine unterschätzt, so das keine Gelder für den Bau weiterer, teurer Geräte bewilligt wurden.

Als eine der wichtigsten technischen Leistungen des Zweiten Weltkriegs gilt Entwicklung, Fertigstellung und Einsatz der auf Ideen von Alan Turing basierenden Colossus-Serie in Großbritannien. Die Röhrenrechenmaschinen wurden unter dem Druck der verbesserten deutschen Chiffriergeräte entwickelt und sollten den deutschen Nachrichtenverkehr entschlüsseln.

Die meiste Forschung in der (Anfangs-)Geschichte des Computers fand jedoch in den USA statt. Der Zweite Weltkrieg konzentrierte das dortige Wissen, und mit enormem Kapitalaufwand wurden die ursprünglich in der Büro und Telefonindustrie genutzten Rechenmaschinen weiterentwickelt und für ballistische Berechnungen verwendet. Gegen Kriegsende wurde der auf Überlegungen von John Atanasoff aufbauende Rechner ENIAC aus 18000 Röhren fertiggestellt. ENIAC wurde dann für Berechnungen für den Bau von Atombomben eingesetzt. (Keil/Reisin 1984: S.272)

Der hohe Kapital- und Personaleinsatz schuf zusammen mit der durch den Weltkrieg

herbeigeführten, weltpolitischen Machtposition der USA dort die Voraussetzung für die

rasche Fortentwicklung der Computertechnologie auf der im Krieg gelegten Basis.

(Halfmann 1984: S.57f; 171ff)

1949 wurde EDVAC, der erste Rechner mit interner Programmspeicherung nach der bis heute aktuellen von-Neumann-Architektur fertiggestellt. Weitere konzeptgleiche Rechner folgten.

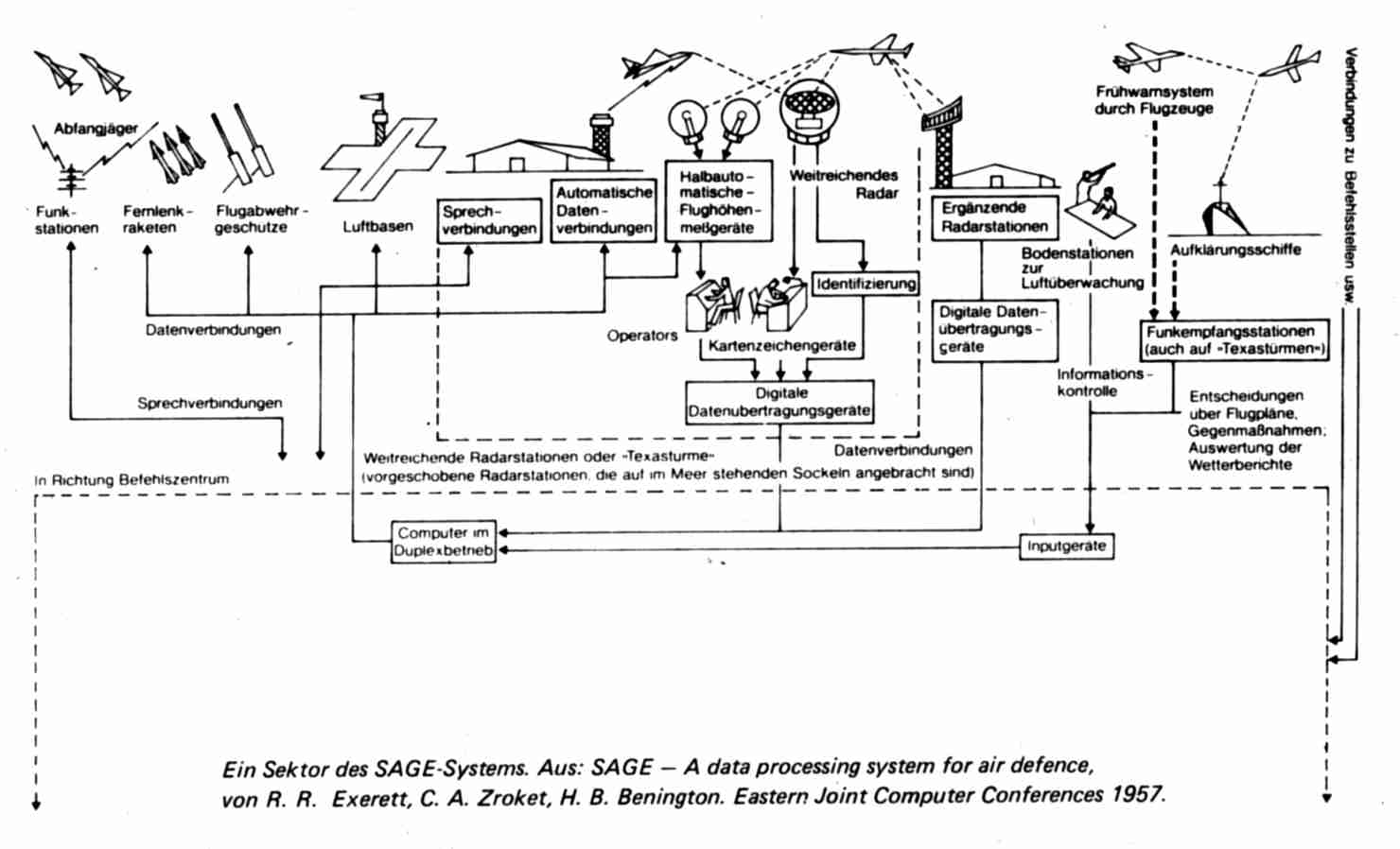

Der "Kalte Krieg" führt zu einer hohen Priorität von Frühwarnsystemen in der Forschung. Nachdem die Russen im Besitz der Atombombe waren, sollten anfliegende Interkontinental-bomber frühzeitig erkannt werden können. Das verhalf dem WHIRLWIND-Projekt, dessen Aufgabe ursprünglich die Flugsimulation sein sollte und das daher auf Echtzeitverarbeitung ausgelegt war, 1950 zu neuem Schwung. Die über Telefonleitungen ankommenden Daten der Radarstationen wurden vom Rechner aufbereitet und im Kontrollraum auf Bildschirmen angezeigt.

WHIRLWIND erfüllte die militärischen Anforderungen nach Erhöhung der Rechen-geschwindigkeit und Zuverlässigkeit und nach Verkleinerung und wird als Prototyp für das ab 1953 in Angriff genommene Luftverteidigungs- und Frühwarnsystem SAGE genommen.

Neu waren eine zentrale Datenleitung im Rechner (main bus), die Entwicklung von Prüfzeichen (parity bit) und Fehler erkennenden Codes zur Fehleranalyse bei der Datenübertragung, der Einbau eines Magnetkernspeichers (Erhöhung der Rechengeschwindigkeit), der Anschluß von Telefonleitungen zur Übermittlung der Radardaten (Datenfernübertragung), die Verwendung von Bildschirmgeräten (Schriftanzeige) und die Benutzung eines Lichtgriffels für Eingaben.

SAGE hat 20 Mrd. Dollar gekostet, in jedem Rechner waren fast 60.000 Röhren und 2 Mio. Ferritkernspeicher eingebaut. Neben den enormen Anforderungen an die Hardware setzte SAGE neue Maßstäbe für die Software (250 Mio. Dollar).

( Lindner, Wohak, Zetwanger 1984: S. 84,119,132 )

Das WHIRLWIND-/SAGE-Projekt kann als der Anfang einer langen Entwicklung hin zum "vollautomatisierten Schlachtfeld" gesehen werden, von rein passiver Luftüberwachung hin zu einem System, dem die Zielauswahl für die Interkontinentalraketen übertragen wurde, das wichtige Entscheidungs- und Auswertungsfunktionen übernimmt und das für die Verknüpfung von Teilsystemen sorgt. SAGE ist der Prototyp für die mit C³I (command, control, communication and intelligence) bezeichneten Frühwarn- und Entscheidungssysteme.

(Iburg 1991: S. 95ff)

Auch wenn SAGE neue technische Impulse geliefert hat (Ferritkernspeichertechnologie), wurde das System in den 60er Jahren aufgrund unüberschaubarer und nicht mehr handhabbarer struktureller Komplexität mit der Folge schwerer Funktionsbeeinträchtigungen aufgegeben. So funktionierte etwa die Freund-Feind-Erkennung nur unzureichend. (Fallows 1984: S.59)

Ab 1957 wurden die Röhren durch die kleineren und energiesparsameren Transistoren abgelöst. So wird für die Steuerung der ersten Interkontinentalrakete 1957 ein Computer auf Transistorbasis verwendet.

1959 wurde das Modell 7090 von IBM für das Frühwarnsystem BMEWS (Ballistic Missile Early Warning System) in Betrieb genommen. Der Rechner 7090 stellte sich als eine sehr zuverlässige Maschine und als Verkaufsschlager heraus, mehrere hundert wurden auch für zivile Anwendungen abgesetzt. Der Anschaffungspreis lag bei rund 3 Mio. Dollar. (Rosen 1969: S. 23f)

1960/61 wurden mit LARC und STRETCH die bis dahin leistungsfähigsten und größten Rechner für die US-Atomenergiebehörde in Betrieb genommen. Die enorme Anzahl von 150.000 bis 160.000 eingesetzten Transistoren erforderte eine industrielle Großfertigung dieser Schaltelemente und verhalf damit dem transistororientierten Rechner zum Durchbruch. Der Übergang von Röhren zu Transistoren markiert die Einführung der zweiten Computergeneration. (Keil-Slawik 1985: S. 24f)

Militärische Forschungs- und Entwicklungsprogramme stellten auch in den 60er Jahren rigorose Leistungsanforderungen an die Elektronikindustrie. Die Anforderungsprofile zielten auf Miniaturisierung, hohe Leistung und Zuverlässigkeit.

Anfang der 60er Jahre führte die durch technologische Innovation bedingte Vielfalt der Waffensysteme zu einer Umorientierung in der US-amerikanischen Verteidigungsdoktrin. Präsident John F. Kennedy und Verteidigungsminister McNamara entwickelten die Strategie der flexible Response , um je nach Konfliktsituation flexibel vorgehen zu können. Einher mit der flexiblen Handhabung von Konfliktsituationen ging der flexible Einsatz einzelner Waffensysteme.

Nicht nur Forschung, Entwicklung und Anwendung von Einzelsystemen, sondern die Förderung von Basistechnologien, Programmiersprachen und Anwendungsgrundlagen standen jetzt im Vordergrund militärischen Interesses. (Keil-Slawik 1985: S.28)

Ab 1962 wurde ein neues Führungs- und Regelsystem für die Minuteman-Interkontinentalrakete entworfen und gebaut. Ziel war es, der Rakete eine größere Selbständigkeit zu geben, durch Übertragung der Steuerung auf Bordrechner.

Verwendet wurden neue platzsparendeHalbleiterelemente. So verhalfen die Aufträge für die Minuteman II-Interkontinentalrakete den integrierten Schaltkreisen ("Integrated Circuit",IC) der 3. Computergeneration zum Durchbruch.

Das war der Beginn der eingebetteten Systeme (Embedded Systems), heute sind nahezu alle Waffensysteme mit kleinen eingebauten Computern ausgestattet.

Die Anforderungen an die 3. Generation waren Miniaturisierung, Erhöhung der

Zuverlässigkeit und Funktionsgeschwindigkeit und Senkung der Herstellungskosten.

Ab Mitte der 60er Jahre übernahm der zivile Markt gegenüber dem militärischen die Rolle des stärksten Nachfragers.

Anfang der 70er Jahre gelang es, einen kompletten Prozessor auf einem Chip unterzubringen, der Beginn der 4. Computergeneration.

Die Entwicklungsrichtung der Computertechnologie in den 80er Jahren war wiederum stark militärisch beeinflußt. So initiierte das Department of Defense 1979 das Programm zur Entwicklung der Programmiersprache Ada und das hardwaretechnologische Forschungs- und Entwicklungsprogramm VHSIC ("Very High Speed Integrated Circuits") zur Erhöhung der Geschwindigkeit und weiteren Miniaturisierung der integrierten Schaltkreise.

Das Schlagwort der 5. Generation war durch ein ziviles staatliches Forschungs- und Entwicklungsprogramm der japanischen Regierung geprägt. Dabei handelte es sich in erster Linie um intelligente Software. Beispiele sind neuartige Expertensysteme und Roboter mit künstlicher Intelligenz. Im Gegensatz dazu waren entsprechende amerikanische Bestrebungen militärisch geprägt. 1983 wurde ein 10 jähriges Programm gestartet. Es gab Ideen, Maschinen mit menschenähnlichen Fähigkeiten zu entwickeln, die in atomar und chemisch verseuchtem Gebiet operieren können. (Hug (1984)) Geplant waren unbemannte Fahrzeuge, die sich ihren Weg selbst mit Hilfe visueller Sensoren suchen, automatische Co-Piloten, die menschliche Sprache verstehen, ein Expertensystem, das den Kommandeuren der amerikanischen Streitkräfte Vorschläge zur Kriegsstrategie unterbreiten und sie vor anstehenden Problemen warnen sollten.

Für derartige Ziele sind umfangreiche Arbeiten auf den Gebieten der Spracherkennung,

Mustererkennung, künstlichen Intelligenz etc. erforderlich, so daß ihre Verwirklichung auf

internationale Zusammenarbeit angewiesen ist.

Schnelle Transistoren und im Rechner eingebaute Speichermedien, die einen raschen Zugriff auf Daten und Programme zuließen, förderten die Entwicklung höherer Programmiersprachen wie FORTRAN (1954) und COBOL (1960), so daß sich die Softwareproduktion zunehmend von der Hardwarestruktur ablöste.

Spielte anfangs die Software nur eine untergeordnete Rolle, so begannen Hardware- und Softwareentwicklung sich in den 60er Jahren mit der 3. Computergeneration auseinander zu entwickeln. Aufgrund der stark gewachsenen Leistungskapazität der Hardware nahm die Bedeutung von Programmen zur Steuerung der Betriebsmittel (Betriebssystem) im Verhältnis zur Hardware zu. Gleichzeitig wurde die Anwendungssoftware zu einem wichtigen Bestandteil der Forschung. Softwareherstellung wurde zu einem wichtigen ökonomischen Faktor.

(Reisin 1985: S. 37f)

Zu dieser Zeit entstanden neue, neuartige Probleme. Die während der 50er Jahre üblicherweise ad-hoc entwickelten Methoden und Verfahren der Softwareentwicklung versagten angesichts des Umfangs und der Komplexität der Anforderungen. Die durch die Hardware gebotenen Möglichkeiten konnten zunächst nicht voll ausgeschöpft werden, was zum Begriff Softwarelücke führte.

Viel gravierender noch waren die schlechte Qualität und die unvorhersehbaren hohen Kosten der oft mit zeitlicher Verzögerung fertiggestellten Systeme. So war der Verlust der Raumsonde Mariner auf Softwarefehler zurückzuführen. (Eggeling 1984: 82f)

Diese Problematik prägte den Begriff Softwarekrise. Das US-Verteidigungsministerium startete daraufhin eine Initiative, zu der auch Konferenzen in den Jahren 1967 bis 69 gehörten, zu denen auch ausländische Wissenschaftler Zutritt hatten. Damit wurde teilweise die strikte Geheimhaltung, die bis dahin die Softwareprojekte umgeben hatte, aufgegeben.

Die beiden wichtigsten und teuersten Projekte in den 70er und 80er Jahren zur Bewältigung der Softwarekrise waren die Entwicklung der Programmiersprache Ada sowie das Folgeprojekt für Programmentwicklungsumgebungen und Programmiertechniken STARS.

Ada stellte den Versuch zur Vereinheitlichung der im Zuständigkeitsbereich des US-Verteidigungsministeriums verwendeten, mehreren hundert Computersprachen dar. STARSsollte die Produktivität der Programmierer erhöhen.

1976/77 wurden die Spezifikationen für die neue Programmiersprache aufgestellt und die Entwicklung einer, dieser Anforderungen entsprechenden Sprache international ausgeschrieben. Nach Begutachtung der eingegangenen Entwürfe erhielt 1979 der amerikanisch-französische Konzern Honeywell/CII-Honeywell den Auftrag für Ada. Die endgültige Sprachdefinition legte das US-Verteidigungsministerium 1980 fest. 1983 wurde Ada als die einzige Programmiersprache für "defense mission-critical applications" definiert. (Meyer 1984: S. 69) 1983 wurde der ANSI-Standard, 1984 der ISO-Standard vergeben. 1986 wurde Ada zur einzigen Programmiersprache für alle C³I-Systeme der NATO.

Ada fördert strukturierte Programmierung und die Arbeitsteilung durch Modularisierung und unterstützt die Hierarchisierung von Problemen. Dadurch sollten die Softwareentwicklung besser beherrscht und die Kosten klein gehalten werden. (Taube 1983: S. 45) Die Arbeit des einzelnen Programmierers richtet sich dadurch auf kleinere, überschaubare Teile. Diese sind leichter und schneller zu testen und besser von außen zu kontrollieren. Projektleiter erhalten einen Einblick in die laufende Arbeit, die Programme sind leichter nachvollziehbar. Dieses Verständnis hilft bei der an den Kosten- und Zeitvorgaben orientierten Organisation des Arbeitsprozesses und verlagert betriebsintern die Macht über den Arbeitsprozeß der Programmerstellung von den Programmierern auf die Systemmanager. Diese Tatsache stellte eine wesentliche Veränderung gegenüber der früheren Praxis dar, als Manager nahezu vollständig von den Angaben ihrer Programmierer abhängig waren. (Iburg 1991: S.214)

Zum Erfolg von Ada gehörte die Standarisierung, die Möglichkeit zur innerbetrieblichen Kontrolle sowie Verbesserung der Produktivität und Zuverlässigkeit und die breite Verwendung im militärischen Bereich, auch auf internationaler Ebene in der NATO und EG.

Die Kritiker zweifelten die Wirtschaftlichkeit an. Bei Echtzeitanwendungen sollen schlechte Ergebnisse vorgelegen haben. Vor allem aber kritisierten E. W. Dijkstra und C. A. R. Hoare den Umfang von Ada. Nachdem 1978 vier Sprachentwürfe vorausgewählt worden waren, hielt Dijkstra den Entwicklern die aus Anforderungsprofilen und Entwürfen ablesbare Komplexität vor. (Eggeling 1985: S. 154)

Hoare äußerte sich 1980:

"Keiner der bisherigen Belege kann uns das Vertrauen geben, das diese Sprache eines der Probleme vermeidet, die die anderen komplexen Sprachprojekte früher beeinträchtigt haben. ... Zu den ursprünglichen Zielsetzungen der Sprache gehörten Zuverlässigkeit, Lesbarkeit der Programme, formale Sprachdefinition und sogar Einfachheit. Nach und nach wurden diese Zielsetzungen zugunsten der Leistung geopfert, die angeblich durch eine Fülle von Konzepten und notationellen Konventionen erreicht werden sollte; viele davon waren überflüssig, einige sogar gefährlich - wie zum Beispiel die Fehlerbehandlung. Wir erleben noch einmal die Geschichte des Automobilbaus. Unnötige Zusatzausrüstungen und Chromglanz haben den Vorrang vor elementaren Rücksichten auf Wirtschaftlichkeit. ...

Im Sinne eines letzten Auswegs appelliere ich an Sie als Vertreter des Berufsstandes der

Programmierer in den USA und als Bürger, denen es um das Wohlergehen und die Sicherheit

des eigenen Landes und der Menschheit geht: Lassen sie es nicht zu, daß diese Sprache in

ihrem gegenwärtigen Zustand in Anwendungsfällen benutzt wird, wo die Zuverlässigkeit

entscheidend ist, das heißt in Atomkraftwerken, Cruise Missiles, Frühwarnsystemen und

ballistischen Raketenabwehrsystemen. ... " (Hoare 1984: S. 72f)

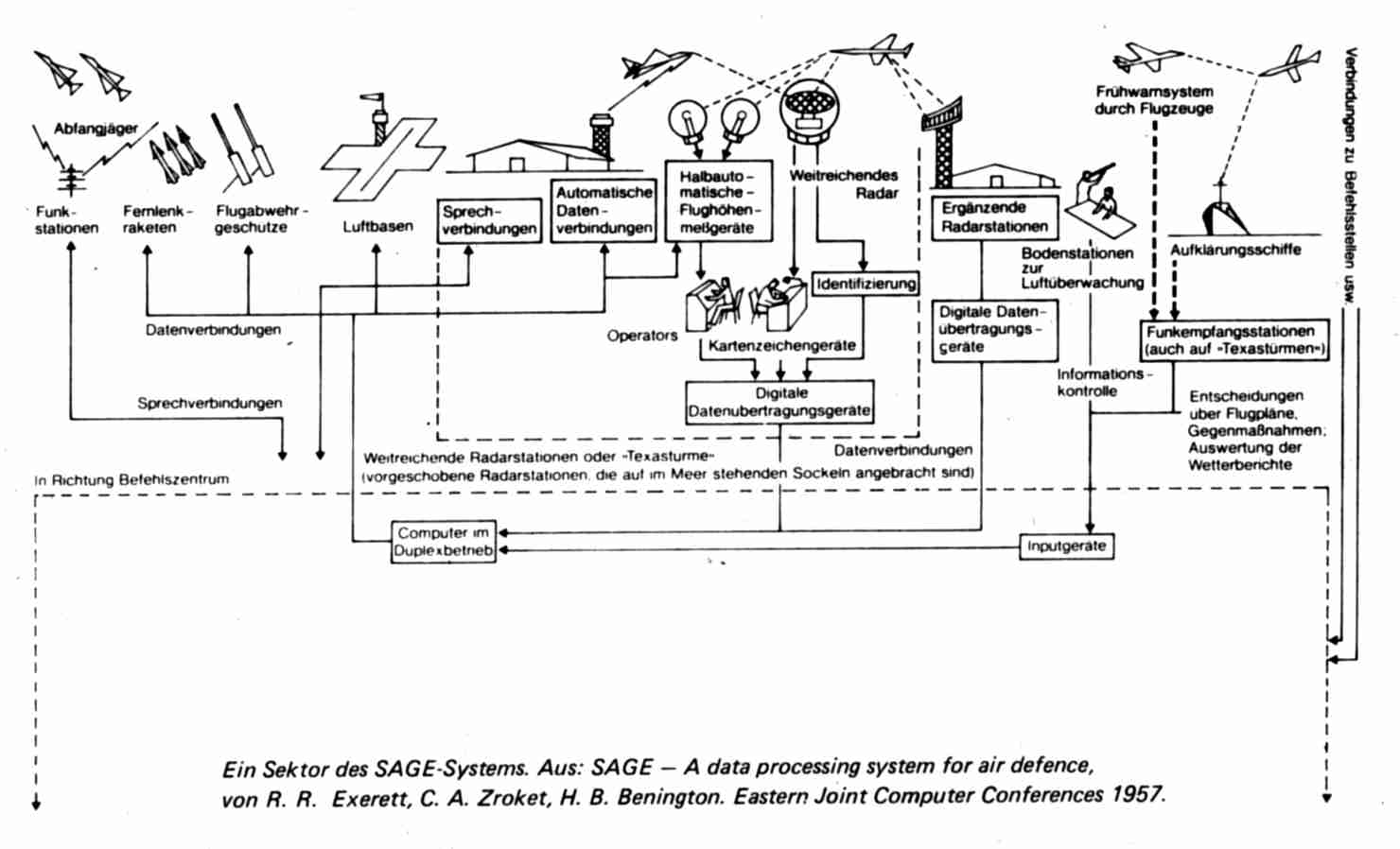

Alle startende Raketen müssen erkannt und innerhalb ihrer 25 minütigen, vierphasigen Flugphase unschädlich gemacht werden. Den Flugphasen entsprechen Bekämpfungsphasen, in denen nacheinander die jeweils verbliebenen Ziele angegriffen werden:

Aus diesen Bekämpfungsphasen ergaben sich entsprechende Anforderungen für das SDI-Forschungsprogramm:

Die bodengestützte Laserwaffe mit den dazugehörigen optischen Systemen in Umlaufbahnen soll die

Interkontinentalraketen während der Antriebsphase abfangen. Der Exzimer-Laser sendet seinen Strahl zu einem

geostationären Fünf-Meter-Spiegel, der seinerseits den Strahl zu einem ähnlichen Kampf- und

Zielverfolgungsspiegel auf einer verhältnismäßig niedrigen Umlaufbahn umlenkt. Dieser Spiegel würde dann

den Strahl auf die aufsteigende Antriebsrakete ausrichten. Der pulsierende Laser soll der Streuung des anderen

entgegenwirken.

Die bodengestützte Laserwaffe mit den dazugehörigen optischen Systemen in Umlaufbahnen soll die

Interkontinentalraketen während der Antriebsphase abfangen. Der Exzimer-Laser sendet seinen Strahl zu einem

geostationären Fünf-Meter-Spiegel, der seinerseits den Strahl zu einem ähnlichen Kampf- und

Zielverfolgungsspiegel auf einer verhältnismäßig niedrigen Umlaufbahn umlenkt. Dieser Spiegel würde dann

den Strahl auf die aufsteigende Antriebsrakete ausrichten. Der pulsierende Laser soll der Streuung des anderen

entgegenwirken.

(Aus: Spektrum der Wissenschaft, Rüstung und Sicherheit 1985)

Neben den zu entwickelnden Waffen stellte die benötigte Software eine Herausforderung nie dagewesenen Ausmaßes dar. Sensoren und vor allem die Gefechtsführung wären der anspruchsvollste Verwendungsbereich für Computer- und Softwaretechnologie. Das Gefechtsführungssystem (Battle-Management-System) muß mit mehreren tausend Objekten zur gleichen Zeit umgehen können. Die zu dessen Planung in Auftrag gegebene McMillan-Studie teilt das System in mehrere lokale Subsysteme und ein globales System.

Zu den Aufgaben der lokalen Systeme gehören:

Zu den Aufgaben des globalen Systems gehören:

Das Battle-Management-System muß aufgrund der hohen benötigten Ablaufgeschwindigkeit voll automatisiert sein.

Die Software muß unter anderem Algorithmen zum Umgang mit Unsicherheit haben, z.B. zur Einschätzung nur teilweise vernichteter Ziele oder schwer unterscheidbarer Objekte.

Der benötigte Umfang wird auf 10 Mio. Codezeilen geschätzt. (DTS 1984: S.10)

a) Es ist unmöglich, ein System zu bauen, dem nicht vorher die Eigenschaften der zu bekämpfenden Ziele und Täuschkörper bekannt sind.

b) Es sind keine Voraussagen über das Zusammenwirken der einzelnen Systemkomponenten möglich. Das schließt auch gegnerische Gegenmaßnahmen und Ausfälle mit ein.

c) Realistische Tests vor einem tatsächlichen Einsatz sind nicht möglich.

d) Der tatsächliche Einsatzzeitraum wird zu kurz für menschliche Eingriffe und Fehlerbeseitigung sein.

e) Aufgrund der fehlenden Zielinformationen kann die Zahl notwendiger Datenverarbeitungen nicht vorausgesagt werden.

f) Es handelt sich um das größte, jemals produzierte Softwaresystem, je größer das System, desto größer die Probleme.

(Parnas: 1985)

Der größte Teil der Raketen sollte in der Startphase zerstört werden, die nur maximal 300 Sekunden lang ist. In dieser Zeit müßten riesige Mengen an Daten verarbeitet, Strategien entwickelt und Feuerbefehle gegeben werden. Dieser Aufgabe kann kein Mensch gewachsen sein, da es nicht möglich ist, unter diesen Umständen den Überblick zu bewahren, klar und konsequent Gegebenheiten abzuschätzen und Gegenmaßnahmen einzuleiten. Es bleibt zu befürchten, daß nicht einmal der Präsident der Vereinigten Staaten in der Lage ist, eine Entscheidung über den Beginn von "Star Wars" zu fällen. (Holl: S.150)

Schließlich sind auch Gegenmaßnahmen zu SDI möglich:

(Bethe, Garwin ,Gottfried, Kendall 1985: S. 76)

Eine Verwirklichung von SDI hätte das strategische Gleichgewicht auch bei schrittweiser Stationierung aus dem Lot gebracht.

(Bethe, Garwin ,Gottfried, Kendall 1985: S. 78)

So liegt es auf der Hand, für Zielsuche, also dem Entdecken eines angreifenden Flugkörpers, und Zielverfolgung nach passiven Verfahren zu suchen. Hier bietet die Optronik, das ist die Zielerfassung mit optischen Mitteln in Verbindung mit einer elektronischen Bilddarstellung und -auswertung in Echtzeit, neue Möglichkeiten. "Optisch" bezieht sich hier nicht nur auf den sichtbaren Wellenlängenbereich, sondern auch auf Ultraviolett und Infrarot. Ein teleskopisches Beobachtungsvisier wird mit einer Videokamera verbunden, das Bild kann an einem geschützten Ort auf einem Monitor beobachtet werden. Wichtiger noch ist die Möglichkeit, Ziele im digitalisierten Bild automatisch zu entdecken und zu verfolgen. Vorteile gegenüber dem Radar sind neben der Möglichkeit, unentdeckt zu bleiben, der niedrige Preis für die Kamera und die hohe Auflösung. Nachteil ist, auf gute Sichtverhältnisse angewiesen zu sein. Die gewünschte Einsatzfähigkeit bei Nacht und dunstigen Tagbedingungen erhält man durch Einbeziehung des infraroten Wellenlängenbereichs. Der gerätetechnische Aufwand ist jedoch unverhältnismäßig höher als im sichtbaren Bereich, es ist eine aufwendige Wärmebildkamera erforderlich. Das entscheidende Charakteristikum der Temperaturstrahlung ist, daß sie unabhängig von einer Beleuchtung vorhanden ist, also auch nachts. Außerdem wird sie nicht durch kleine Schwebeteilchen in der Atmosphäre wie Dunst und Gefechtsrauch aufgehalten.

Auch im Ultravioletten gibt es Anwendungen der Optronik für die Flugabwehr. Unterhalb einer Wellenlänge von 0,3m hält die Ozonschicht der höheren Atmosphäre das Sonnenlicht ab. Aber gerade in diesem Bereich strahlen Flugkörpertriebwerke eine erhebliche Leistung ab. Eine Kamera in diesem Bereich zeigt also den Start und die Antriebsphase von Flugkörpern gegen einen weitgehend dunklen Hintergrund, wenn diese nicht zu weit entfernt sind. Erste Anwendung findet sich als Warner vor Flugkörpern an Bord von Flugzeugen.

Ein ganz wesentlicher Teil eines optronischen Gerätes ist die Hard- und Software für die Bildverarbeitung. Folgende Problembereiche treten auf:

Ein Punktziel liegt vor, wenn das Bild aufgrund der Entfernung / Größe des Objekts aus nur einem Pixel / einem kleinen Haufen von Pixels besteht. Die Form des Zieles steht dann als Ansatz für die Bildverarbeitung nicht zur Verfügung. Es bleiben als Merkmale nur die Intensität und der Ort als Funktion der Zeit. Aufgabe eines Algorithmus ist es, durch Spurbildung die echten Ziele von den mehr statisch fluktuierenden Falschzielen zu unterscheiden, da meistens Tausende von punktförmigen Objekten als potentielle Kandidaten vorhanden sind.

Erscheint das Ziel hinreichend groß, kann seine Form durch Bildverarbeitungsalgorithmen analysiert werden. Diese werten Formmerkmale des Ziels aus, die es vom Hintergrund, z.B. Wolkenstrukturen, unterscheiden. Nach einer ersten Zuweisung des Objekts durch einen Bediener oder durch Radar sucht der Algorithmus in jedem neuen Bild nach vom vorhergehenden Bild gespeicherten Merkmalen. Dem Bediener bietet das Bild des Ziels wegen der hohen Auflösung im Gegensatz zum Radar die Möglichkeit zur Identifizierung.

Bei sehr widrigen Witterungsverhältnissen kann auf Radar nicht verzichtet werden, eine Kombination kann jedoch die aktiven Radarphasen minimieren.

(Jansen 1998: S.36f)

Aufklärungsfotos aus Flugzeugen und Satelliten dienen den USA seit den 50er Jahren dazu, über im Ausland stationierte amerikanische Truppen zu wachen, Abrüstungsvereinbarungen zu kontrollieren, gegnerische Streitkräfte einzuschätzen und Rüstungsprogramme zu planen. Gerade Ende der 50er und Anfang der 60er Jahre lieferte die mit modernen technischen Mitteln betriebene Bildaufklärung mehrfach zur rechten Zeit wichtige Informationen für die Vorbereitung politischer Entscheidungen und trug mitunter sogar dazu bei, eine Konfrontation zwischen den Weltmächten zu entschärfen. In der Mehrzahl der Fälle bewahrten diese Aufnahmen die USA vor unliebsamen Überraschungen und zeigten , daß die Waffenarsenale des Gegners weniger bedrohlich und dessen Absichten weniger finster waren als zunächst angenommen.

War die Bildauswertung anfangs noch Handarbeit, so stehen jetzt immer bessere

elektronische Methoden zur Verfügung. Neue Speichermedien erfordern weit weniger Platz

in den Archiven und erlauben einen schnelleren Zugriff auf das gesamte Bildmaterial. Mit

Bildbearbeitungs-verfahren lassen sich interessante Objekte und Muster leichter erkennen,

und zum Vergleich kann eine Vielzahl früherer Aufnahmen des selben Ortes oder ähnlicher

Anlagen herangezogen werden. Mittels fotogrammetrischer Methoden lassen sich anhand der

Satelliten- und Kameradaten (Entfernung zum Objekt, Blickrichtung, Brennweite) die

Ausmaße des Objekts berechnen. (Brugioni 1996: S. 68f)

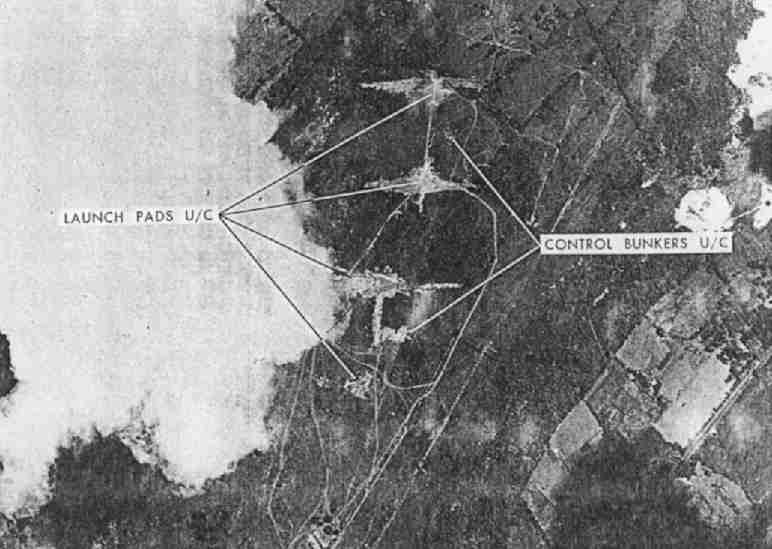

Während der Kuba-Krise stützten sich die

amerikanischen Bildauswerter in erster Linie auf

die Erfahrungen, die sie beim Ausspähen von

Raketenabschußbasen auf sowjetischem

Territorium gemacht hatten. Solche keilförmigen

Signaturen wie hier waren schon häufiger in den

UdSSR beobachtet worden, so daß man sie

eindeutig als im Bau befindliche Anlagen für den

Abschuß von Mittelstreckenraketen des Typs SS-5

zu identifizieren vermochte. Die Bildauswerter schufen einige seltsame Disziplinen wie etwa

die "Zeltologie". Aus Anzahl und Typen der Zelte in vier

sowjetischen Militärlagern auf Kuba während der Raketenkrise

vermochten sie abzuschätzen, daß sich dort jeweils etwa 1500

Soldaten aufhielten. Die akkurate Ausrichtung der Zelte und die

geordnete Aufstellung modernster militärischer Ausrüstung

waren ein Indiz dafür, daß es sich eher um sowjetische

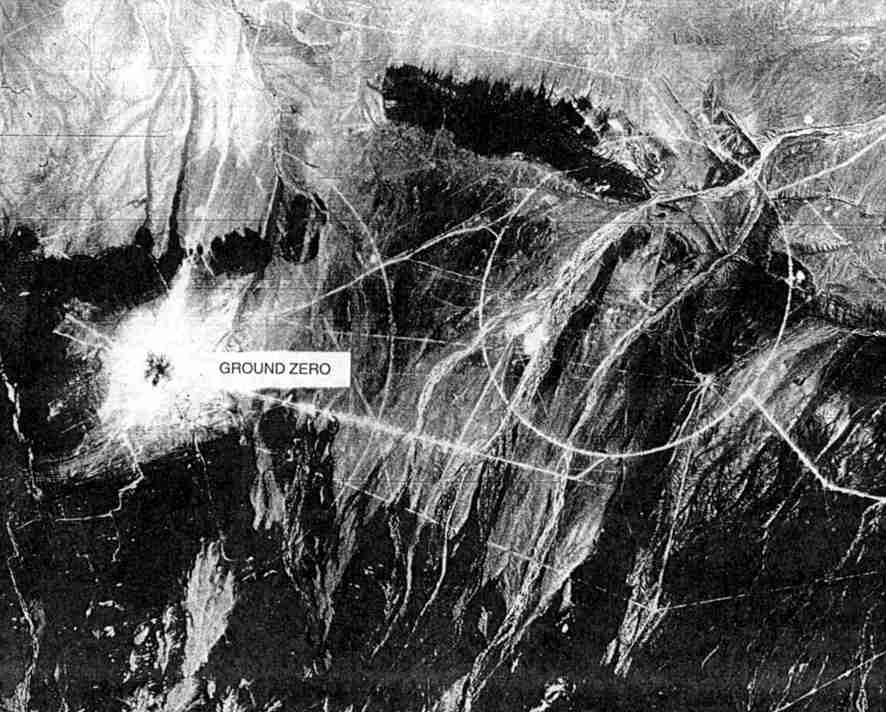

Elitetruppen als um kubanische Streitkräfte handelte. Als immer mehr Staaten mit dem Bau von Raketen

und Massenvernichtungswaffen begannen, wurden

Wüsten und andere entlegene Landstriche zu

Testgebieten. Die Bildauswerter betrachteten

Aufnahmen aus solchen Regionen stets mit

besonderer Sorgfalt, und hin und wieder

entdeckten sie etwas, das es ihnen ermöglichte,

bedeutsame Ereignisse vorherzusagen. Im

Dezember 1961 zeigten Fotos der Lop-Nur-Region

in der Taklimakan-Wüste im Nordwesten Chinas

eine auffällige kreisrunde Straße mit einem

Durchmesser von 4000 Metern. Ihre Lage und

Abmessung ließen vermuten, daß sie zu einem

geplanten Atomtestgelände gehörte; die

umschlossene Fläche war groß genug, um in der

Mitte eine oberirdische Kernexplosion zünden zu

können, ohne die Straße zu beschädigen. Ein

Flugplatz, Baracken und sonstige Einrichtungen wurden nach und nach gebaut. Noch später wurde ein 100 Meter

hoher Turm errichtet; als dann Kommunikations- und Datenleitungen zwischen diesem Turm und Meßstationen

verlegt wurden, die sich auf Lastwagen und in Bunkern befanden, konnte es nur noch wenige Wochen bis zum Test

sein. Die US-Regierung gab die vermeintlichen Aktivitäten öffentlich bekannt, um der chinesischen Regierung den

propagandistischen Effekt zu verderben. Die Auswertungen einer Aufnahmeserie vom 8. Oktober zeigte, daß alle

Vorbereitungen für die Testexplosion abgeschlossen und Arbeiter und Ausrüstung aus der unmittelbaren Umgebung

abgezogen worden waren. Am 16. Oktober zündeten die Chinesen schließlich einen 28-Kilotonnen-Sprengsatz. Vier

Tage später fotografierte ein KH-4-Satellit den Explosionsort, an dem anstelle des Turms die Wirkungen einer

oberirdischen Kernexplosion zu sehen sind.

(Aus: Spektrum der Wissenschaft, August 1996) 15. Oktober 1962, Guanajay (Kuba)

15. Oktober 1962, Guanajay (Kuba)

20. November 1962, Holguin-Militärlager (Kuba)

20. November 1962, Holguin-Militärlager (Kuba)

20.Oktober 1964, Lop Nur (China)

20.Oktober 1964, Lop Nur (China)

Ballistische Flugkörper können nach dem Start nicht mehr gelenkt werden, im Gegensatz zu den aerodynamischen, die im allgemeinen einen Bordcomputer zur Steuerung mitführen (Embedded Systems).

Durch den Fortschritt in der Hardware kann mit "intelligenten" Funktionen die Zielannäherung automatisiert werden, man spricht dabei von "intelligenter Zielannäherung" im Vergleich zu fest programmierten Flugbahnen. Die automatische Verarbeitung von Signaturen zur Entdeckung, Identifizierung und Verfolgung eines zu bekämpfenden Ziels stellt hierbei technologisch die größte Herausforderung. (Jansen 1998: S.34ff)

Folgende unbemannte Systeme sind zu nennen:

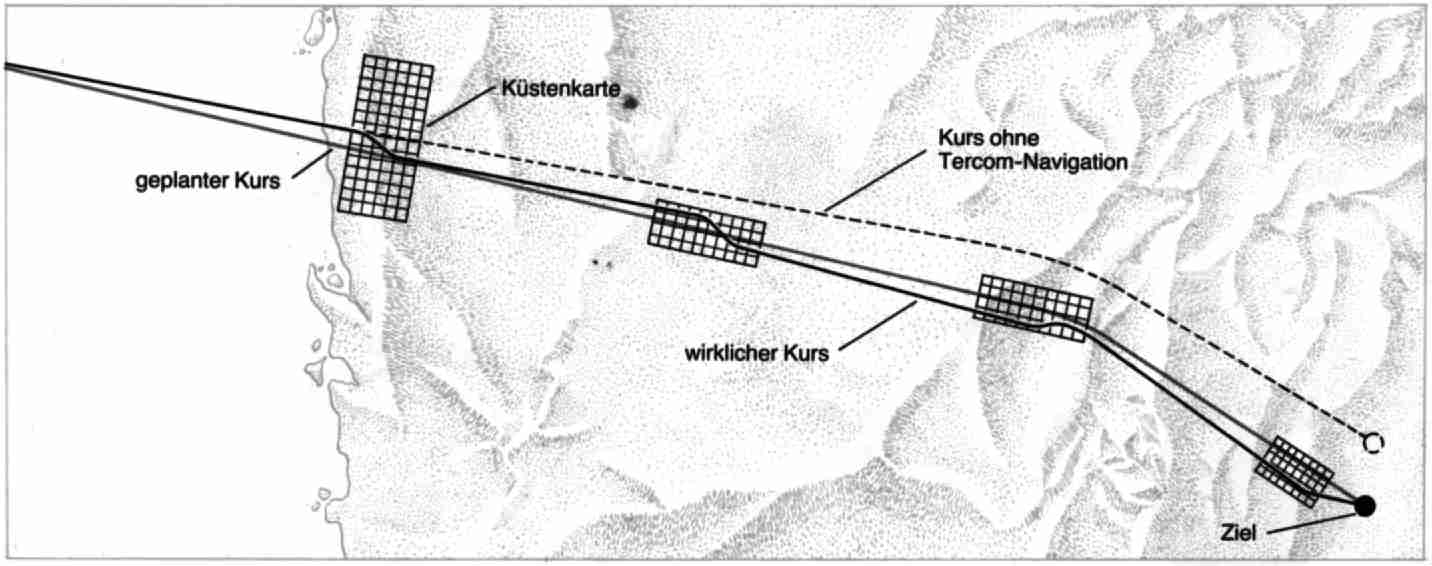

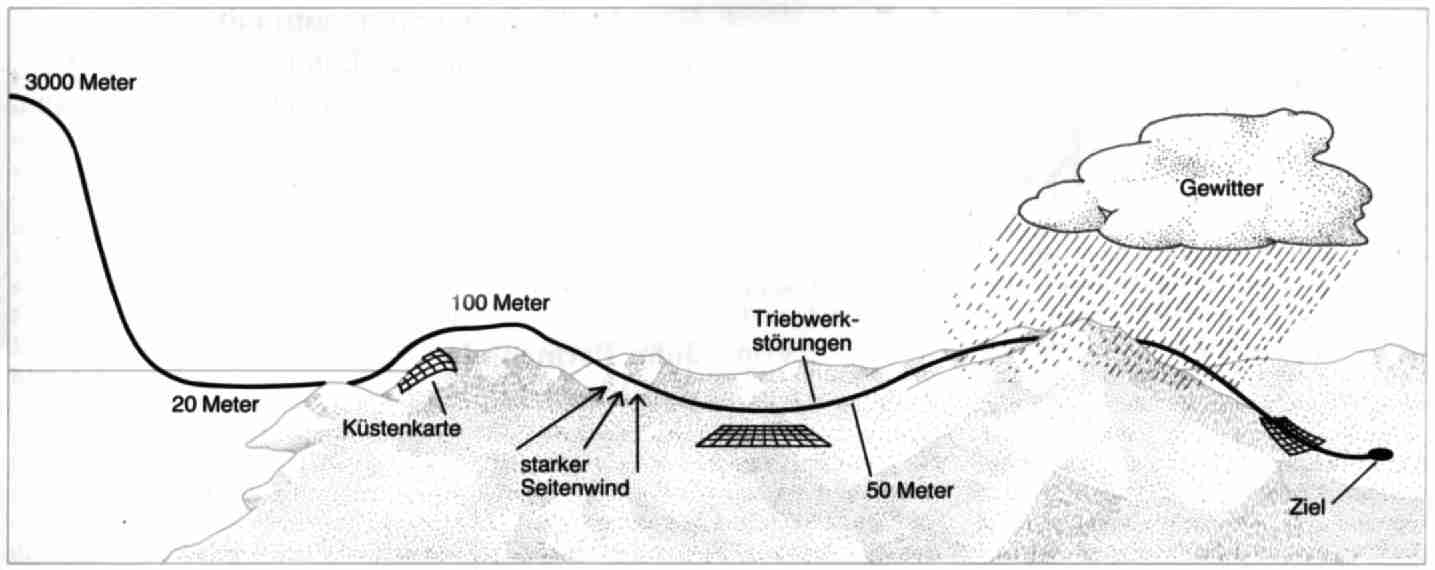

Terrain-Contour Matching (Tercom) ist eines der Zielleitsysteme für Marschflugkörper. Im Bordcomputer wird eine

gespeicherte, digitalisierte Landkarte mit Höhenmessungen verglichen, diebeim Abtasten eines ausgewählten

Gebietes durch den Bordradar entstehen. Die Landkarten bestehen aus einem Muster kleiner Quadrate, deren

mittlere Höhenlage über dem Meer bekannt ist. Nähert sich der Flugkörper einem Gebiet, dessen Karte im Speicher

des Bordcomputers mitgeführt wird, beginnt der Radarhöhenmesser zu arbeiten. Die gemessenen Höhen werden

vom Computer mit den gespeicherten Daten verglichen und der wirkliche Kurs des Flugkörpers bestimmt.

Notwendige Kurskorrekturen werden an den Autopiloten weitergegeben. Auf dem oberen Bild sind vier

Anpassungsmanöver der Cruise Missile aus vertikaler Sicht dargestellt. Im unteren Schema läßt sich der letzte Teil

der Flugstrecke ablesen. Aus Gründen der Treibstoffersparnis bewegt sich der Marschflugkörper zunächst in großer

Höhe und geht erst kurz vor dem feindlichen Luftraum in Tiefflug über.

(Abbildung aus Spektrum der Wissenschaft, Rüstung und Abrüstung 1983)

Der Einsatz moderner Zielflugkörper wird über eine "intelligente" Waffeneinsatzanlage gesteuert. Die Flugbahn wird über Wegpunkte vorgegeben und kann die direkte Verbindung oder einen anderen Weg beschreiben, falls Hindernisse die Strecke versperren, bzw. um den Standort der Abschußanlage zu verschleiern. Die Waffeneinsatzanlage plant auch die Flugzeiten, um bei Einsatz einer Salve von Flugkörpern alle zum gleichen Zeitpunkt aus unterschiedlichen Richtungen am Ziel eintreffen zu lassen. Wenn der Typ der Zielanlage mit seiner Abwehrbewaffnung bekannt ist, muß auch die Erfolgswahrscheinlichkeit berechnet werden. Hierbei wird in einer Simulation anhand der vorgegebenen Flugbahn die Erfolgswahrscheinlichkeit unter Berücksichtigung der gegnerischen Flugabwehr berechnet, um eine Salve so zu planen, daß die Trefferwahrscheinlichkeit erhöht wird.

Ein moderner Zielflugkörper hat einen Radar- oder Infrarotsuchkopf, kann Hindernissen selbstständig ausweichen und sein Ziel punktgenau treffen. Ein passives Infrarotsystem hat den Vorteil, vom gegnerischen Radar nicht geortet zu werden, was durch eine Stealth-Formgebung des Flugkörpers noch unterstützt werden kann.

Ein Radar- oder Infrarotsuchkopf ist gut geeignet, um Ziele auf dem offenen Meer zu treffen, da diese sich vom Hintergrund abheben. Für Landziele wäre eine intelligente Bildverarbeitung notwendig. Ein Lenksystem mit GPS (Global Positioning System) ermöglicht jedoch das genaue Anfliegen eines Zieles, dessen geographische Koordinaten bekannt sind.

(Hambrock 1998: S. 22ff)

GPS-Geräte beziehen ihre Informationen von maximal 24 Satelliten, die in geostationären

Bahnen ihre Signale aussenden. Weltweit und unabhängig von Wetterverhältnissen können

die Signale rund um die Uhr empfangen und in Positionsdaten umgewandelt werden.

(Hofmann 1987: S.11ff, Druhm 1997: S. 30ff, Hodouschek 1998: S.24ff)

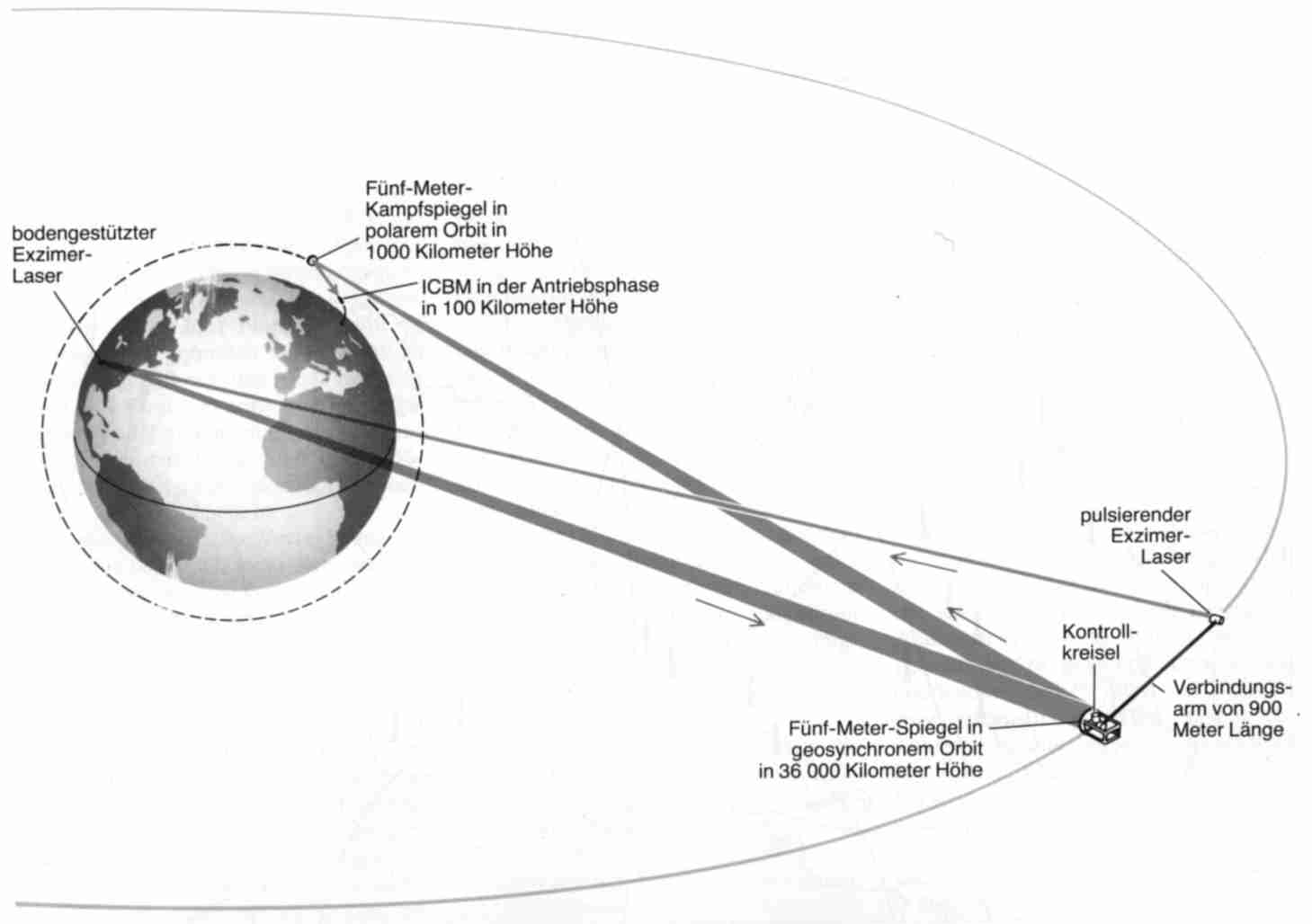

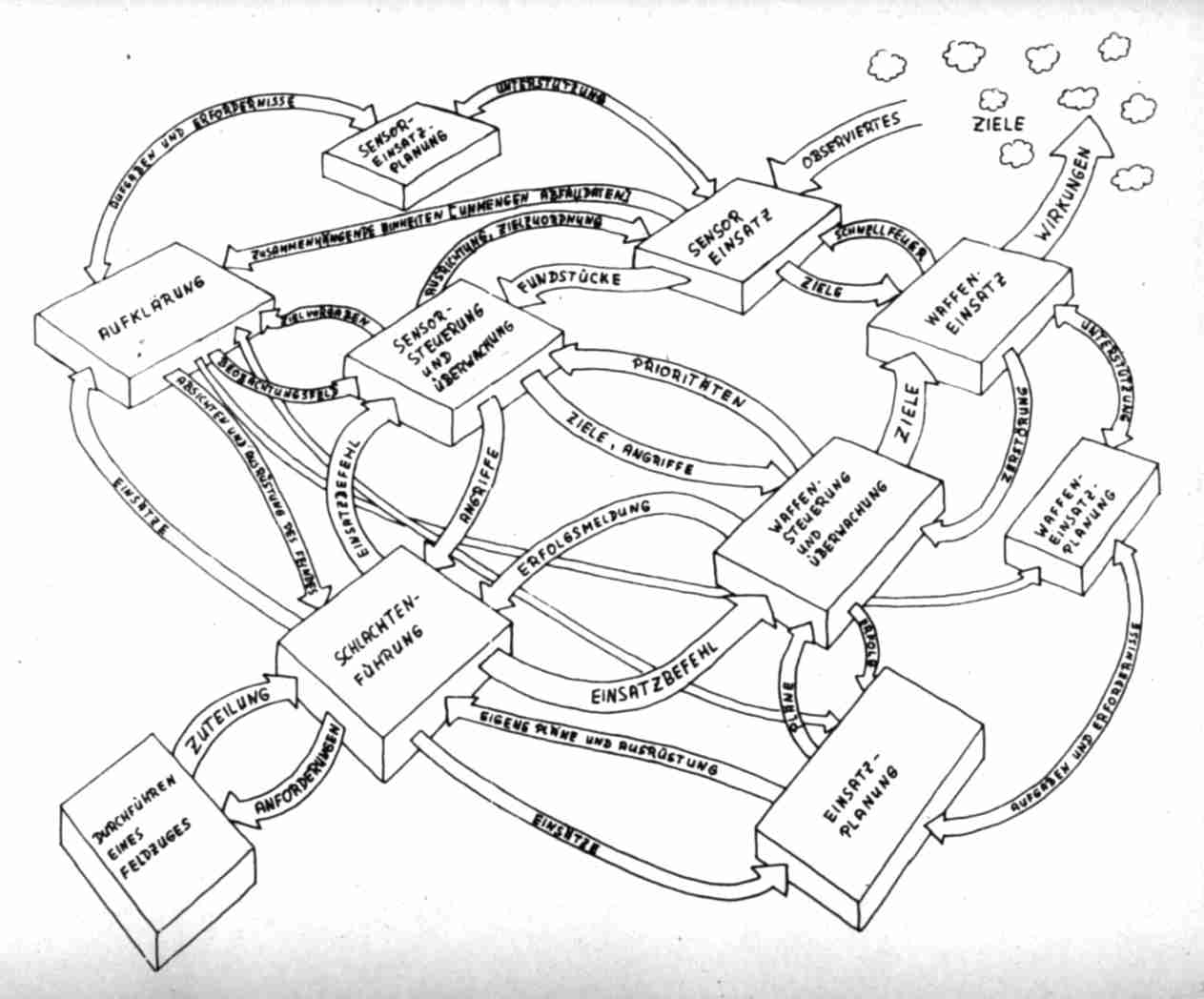

Schema eines

Führungs-informations-,

Fernmelde-, und

Aufklärungssystems

(Aus: Slawik 1985: S. 155)

Aufbauend auf dieser Zielsetzung wurde zehn Jahre später das Kommunikationsprotokoll TCP/IP (Transmission Control Protocol/Internet Protocol) für das heutige Internet entwickelt. Diese ursprüngliche Zielsetzung des Internet-Protokolls ist die Ursache dafür, das sich dieses Netzwerk seit Beginn der 80er Jahre bis heute praktisch ohne zentrale Steuerung und Planung mit rasender Geschwindigkeit ausbreitet. Das Wachstum findet dabei an unzähligen Stellen gleichzeitig statt und ist kaum kontrollierbar. Trotzdem stellt das Intenet, wie ursprünglich von Militärstrategen konzipiert, ein außerordentlich zuverlässiges Kommunikationsmedium dar.

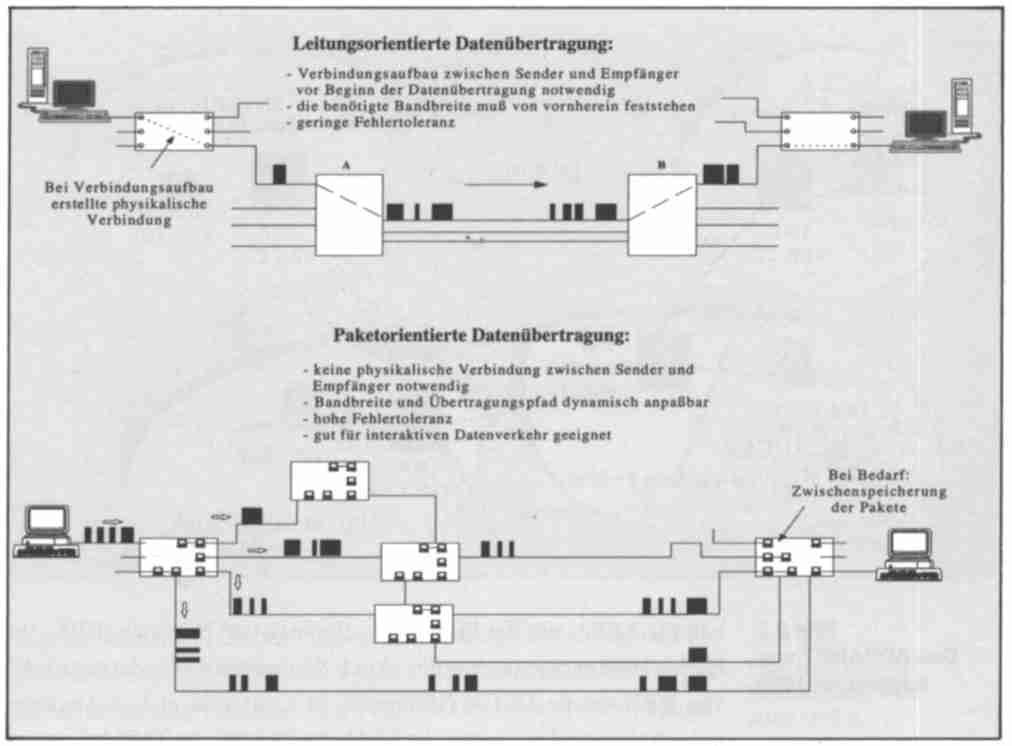

Die anfänglich angewandte Technik der leistungsorientierten Datenübertragung war für

militärische Zwecke nicht zuverlässig genug. Zur leistungsorientierten Datenübertragung ist

der Aufbau einer physikalischen Verbindung zwischen Sender und Empfänger notwendig,

bevor Daten überhaupt übertragen werden können. Wird diese Leitung unterbrochen, so wird

damit auch die Datenübertragung sofort und unmittelbar unterbrochen. Die dann neu

entwickelte paketorientierte Datenübertragung war dagegen wesentlich unempfindlicher

gegenüber Störungen in der Übertragungsinfrastruktur und sollte in den folgenden Jahren die

Datenkommunikation revolutionieren.

Bei paketorientierter Datenübertragung werden die zu versendenden Daten in Datenpakete aufgeteilt und diese Pakete jedes für sich über das Netzwerk versendet. Jedes Paket enthält dabei die gesamte Information (Sendeadresse, Empfangsadresse, Sequenznummer), die notwendig ist, um es zum Empfänger zu übertragen und dort gemeinsam mit den anderen Datenfragmenten wieder zur ursprünglichen Information zusammenzusetzen. Abhängig von Verfügbarkeit, Verkehrsbelastung und Übertragungszeit der verschiedenen Netzwerkabschnitte werden die für die jeweiligen Pakete optimalen Übertragungsstrecken gewählt. Die Pakete ein und derselben Datenübertragung können also verschiedene Wege gehen.

(Kyas 1994: S. 29ff)

Die neuen Waffen eignen sich gleichermaßen für Krieg, Kriminalität und Aktionen gegen wirtschaftliche Konkurrenten. Diese Waffen brauchen keine Armeen; neue, schwer greifbare Gegner können überall auftauchen.

Zu den Highlights in dieser Richtung zählt das Einschleusen von Computerviren und logischen Bomben in gegnerische Rechnersysteme. Nach Berichten des Time Magazine präpariert der amerikanische Geheimdienst Hard- und Softwarekomponenten, um sie "feindlichen Nationen" zuzuspielen. (Waller 1995).

Aber auch abseits der Informatik spielen informationstechnische Waffen eine Rolle: Bei einer Atombombenexplosion entsteht ein elektromagnetischer Impuls, der in einem großen Umkreis alle elektrischen Anlagen lahmlegt oder zerstört. Dieser Impuls kann auch durch nicht-nukleare Verfahren erzeugt werden.

Neben der schon oben erwähnten intelligenten zielsuchenden Munition und den Simulatoren sind weitere Hightech-Anwendungen Aufklärungs-, Spionage- und Störelektronik und in naher Zukunft möglicherweise vollautomatische Kampfroboter.

Die Informationstechnik entpuppt sich als sicherheitspolitisch zweischneidiges Schwert. Der Fortschritt bei Computern und Netzwerken verbreitert nicht nur die Machtbasis, sondern erhöht auch die Verwundbarkeit, wie das Eindringen von Hackern in staatliche und militärische Computersysteme belegt. Dabei sind die Kosten für potentielle Angreifer niedrig; PC, Modem und Internetzugang genügen. Damit kommen als Gegner nicht mehr nur Staaten und deren Militärapparate in Frage, sondern destruktionsfreudige Freizeithacker, Drogenkartelle, Terrororganisationen und bestimmte religiöse Sekten.

(Teilweise übernommen aus: Baumann 1998: S.80ff)

Am 25.Januar 1995 tauchte auf den Bildschirmen einiger Radarstationen in Nordrußland unvermittelt ein Leuchtfleck auf, der die Diensthabenden in Aufregung versetzte: Unverkennbar stieg eine Rakete, irgendwo vor der Küste Norwegens gestartet, mit großer Geschwindigkeit in den nächtlichen Himmel empor.

Die Operateure wußten: Sollte es sich um einen ballistischen Flugkörper eines in diesen Gewässern operierenden U-Bootes der USA handeln, könnten in weniger als 15 Minuten acht nukleare Sprengköpfe über Moskau detonieren. Vorschriftsmäßig informierten sie umgehend ihre Vorgesetzten. Rasch gelangte die Nachricht über die Spitze des Militärapparates zu Boris Jelzin, der über eine elektronische Einrichtung einen nuklearen Gegenschlag anordnen kann. Eilig beriet sich der Präsident telephonisch mit seinen wichtigsten Beratern. Es war das erste Mal in der Geschichte der Supermächte-Konfrontation, daß der sogenannte Atomkoffer für den Notfalleinsatz aktiviert wurde.

Für einige spannungsgeladene Minuten blieben die russischen Entscheidungsträger über die Flugbahn der mysteriösen Rakete im ungewissen. Die Beunruhigung nahm noch zu, als sich Antriebsstufen abtrennten und dies den Eindruck erweckte, es könnte sich um einen Angriff mit mehreren Trägersystemen handeln. Erst nach etwa acht Minuten, kurz vor Ablauf der festgelegten Frist, nach der ein Gegenschlag auf einen bevorstehenden Atomangriff hin angeordnet werden soll, entschieden höhere Offiziere, daß der Flugkörper für Rußland keine Gefahr darstellte, weil er weit auf das Meer hinaus flog.

Wie bald heraus gefunden wurde, war es ein ziviles, nämlich wissenschaftliches Objekt: eine amerikanische Höhenforschungsrakete, mit der das Nordlichtphänomen untersucht werden sollte. Bereits zuvor hatten die Norweger die russischen Behörden pflichtgemäß über den geplanten Abschuß ... in Kenntnis gesetzt, doch waren diese Informationen nicht bis zu den zuständigen Stellen durchgedrungen. ...

(Aus: Spektrum der Wissenschaft, Blair, Feiveson, von Hippel, April 1998: S. 76ff)

>> Keil/Reisin (1984), Reinhard K., Michaela R., Informatik in militärischen Diensten - Informatiker in sozialer Verantwortung, in: WSI-Mitteilungen, 37. Jg., Nr. 5, Mai 1984

>> Halfmann (1984), Jost, Die Entstehung der Mikroelektronik. Zur Produktion technischen Fortschritts, Frankfurt, New York 1984

>> Rosen (1969), Saul, Electronic Computers: A Historical Survey, in: Computing Surveys, Vol.1, Nr.1, März 1969

>> Fallows, J. (1981): National Defense. New York

>> Lindner, Wohak, Zeltwanger (1984), Rodolf, Bertram, Holger; Planen, Entscheiden, Herrschen. Vom Rechnen zur elektronischen Datenverarbeitung, Reinbek 1984

>> Hug, K.-H. (1984): Strategic Computing Initiative. Informationsdienst Wissenschaft und Frieden;herausgegeben vom Bund demokratischer Wissenschaftler e.V.,Marburg, Heft 3/84

>> Reisin (1985), Fanny Michaela, Softwaretechnik oder Die Geschichte einer unbewältigten Krise, in Bickenbach et al. (1985)

>> Eggeling (1984), Jörn, GOTO - REPEAT UNTIL. Schwierigkeiten mit der Software, in: Kursbuch 75. Computerkultur, März 1984

>> Eggeling (1985), Jörn, Die Industrialisierung von Programmierarbeit. Ihr Ausdruck in Kontroversen um Programmiersprachen undSprachelemente, Frankfurt am Main, Bern, New York 1985

>> Meyer (1984), Deborah G., Ada comes of age: DoD's New Computer Language should help organize chaotic C³I, in: AFJI, Vol. 121, Nr. 7, Februar 1984

>> Taube (1983), Wolfgang, Die Rationalisierung der Softwareproduktion am Beispiel der Entwicklung der Programmiersprache Ada, Berlin 1983

>> Iburg (1991), Holger, Abschreckung und Software, Computertechnologie als Instrument der amerikanischen Sicherheitspolitik, Frankfurt, New York 1991

>> BmVg (1986), Der Bundesminister der Verteidigung. Informations- und Pressestab, Referat Öffentlichkeitsarbeit, SDI. Fakten und Bewertungen. Fragen und Antworten. Dokumentation, Bonn Juni 1986

>> McMillan (1984), Brockway, Report of the Study on Eliminating the Threat Posed by Nuclear Ballistic Missiles (U), James C. Fletcher, Study Chairman, Volume V. Battle Management, Communications, and Data Processing (U), Contract MDA 90384C0021; Task T-3-191, o.O (Washington, D.C.), Februar 1984

>> DTS (1984), The Strategic Defense Initiative. Defensive Technologies Study, Department of Defense, Washington, D.C., März 1984

>> Parnas (1985), David Lorge, Software Aspects of Strategic Defense Systems, in: American Scientist, Vol. 73, No. 5, 1985

>> Holl (1985), Friedrich, Spieglein, Spieglein... Einige Überlegungen zur Beteiligung der Informatik an der Strategic Defense Initiative, in: Bickenbach et al. (1985)

>> Bethe, Garwin, Gottfried, Kendall (1985), Hans A., Richard L., Kurt, Henry W., Raketenabwehr im Weltraum, in: Spektrum der Wissenschaft: Verständliche Forschung, Rüstung und Sicherheit, 1985

>> Jansen (1998), Hugo, Entwicklungen bei der Flugabwehr Am Beispiel der Heeresflugabwehr, in: Europäische Sicherheit (7/98)

>> Brugioni (1996), Dino A., Der Beginn moderner Bildaufklärung, in: Spektrum der Wissenschaft (8/96)

>> Tsipis (1983), Kosta, Marschflugkörper, in: Spektrum der Wissenschaft, Rüstung und Abrüstung 1983

>> Hambrock (1998), Rolf, Seezielflugkörper der nächsten Generation, in: Europäische Sicherheit (8/98)

>> Keil-Slawik (1985), Reinhard, "Intelligente" Kriegsführung ohne Mensch?, Fragen an die Menschen, in: Bickenbach et al. (1985)

>> Preißner (1998), Michael, Die Nutzung von Duellsimulatoren im Regionalen Übungszentrum Nord, in: Europäische Sicherheit (6/98)

>> Hofmann (1987), H. W., Einsatz moderner Informationstechnik im militärischen Bereich: Für den Verteidiger notwendig und verantwortbar, in: Informatik-Spektrum (10/87)

>> Druhm (1997), Frank, Gefechtsfel-Führungssystem des Heeres, in: Europäische Sicherheit (11/97)

>> Hodouschek (1998), Theodor, Die Führungs- und Waffeneinsatzsysteme des Heeres, in: Europäische Sicherheit (1/98)

>> Kyas (1994), Othmar, Internet Zugang Utilities Nutzung, 1994

>> Baumann (1998), Alfred, Bitskrieg Information Warfare: Krieg im Informationszeitalter, in: c't, 1998, Heft 18

>> Waller 1995, Douglas, Onward Cyber Soldiers, Time Magazine 21, August 1995

>> Blair, Feiveson, von Hippel (1998), Bruce G., Harold A., Frank N., Atomraketen: Finger

weg vom roten Knopf, in: Spektrum der Wissenschaft, April 1998

Eine gesellschaftskritische Darstellung findet sich in:

>> Iburg (1991), Holger, Abschreckung und Software, Computertechnologie als Instrument der amerikanischen Sicherheitspolitik, Frankfurt, New York 1991

und in:

>> Bickenbach et al. (1985)

auf das sich Iburg teilweise bezieht.

Zum Thema Abrüstung und den wirtschaftlichen und sozialen Folgen gibt es einen Beitrag in

Spektrum der Wissenschaft:

>> Wulf (1994), Herbert, Konversion - wirtschaftliche und soziale Folgen, in: Spektrum der

Wissenschaft, September 1994

Regelmäßig gibt es aktuelles Material in den Zeitschriften:

>> Spektrum der Wissenschaft und

>> Europäische Sicherheit